浸没式液冷数据中心布线系统应用技术分析(下)

引言

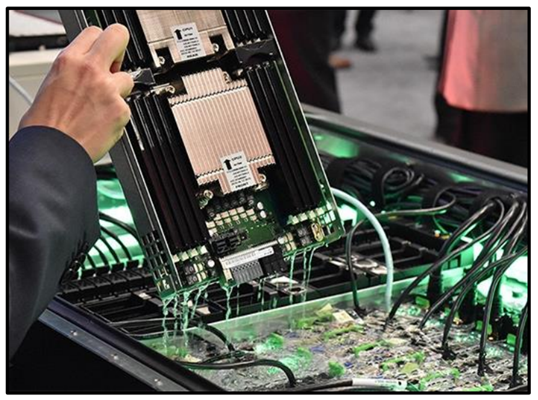

前一期我们的文章《浸没式液冷数据中心技术浅析》中我们已经总体分析了浸没式液冷的技术特点与应用优势与发展的前景。采用浸没式液冷这种技术的最终目的是想要提高数据中心单机柜的功率从而提升单位面积的计算密度,与此同时实现单位能源与资源消耗的最大能效比,即实现绿色节能的目标。所以提升IT设备运行效率是浸没式液冷数据中心追求的目标。而作为IT设备数据通信的纽带即数据中心网络布线系统,我们需要考虑的是当布线系统浸没于冷却液的情况下,需要分析传统的布线系统是否还适合于这种场景,冷却液的化学特性决定了布线系统的材料选择上有不同。如果传输系统采用光学,光学通信接口浸没于冷却液的情况下会有不同的要求等等需要重新考虑。随着网络传输速率从主干100G升级到400G以及未来的800G,对于布线系统性能的敏感性更高。基于此,浸没式液冷数据中心布线系统的要求值得我们作专题探讨。

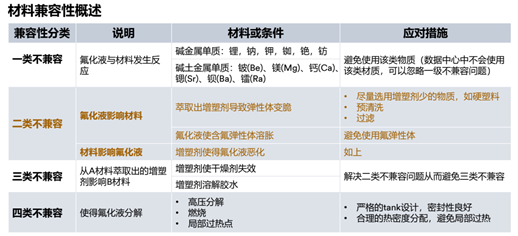

一,冷却液材料兼容性的要求:

由于冷却液是一种复合性的化学材料,当整体布线系统长期浸入冷却液时,需要验证布线系统的每种材料与冷却液的相容性问题,会不会由于长期浸泡产生化学反应而导致出现问题。我们以业界比较知名的3M公司的两种最常用的冷却液用于单相液冷3M? Fluorinert? FC-3283以及两相液冷3M? Fluorinert? FC-72为例,可以参考相关的兼容性的要求如下:

注:材料兼容性分类表来源于3M

二,高带宽对布线系统的要求:

传统数据中心由于采用风冷为主,基于风冷的制冷效率,需要防止服务器过热导致无法稳定运行,这是服务器运算效率无法提升的瓶颈,传统数据中心普遍单机柜的配电量在10KW以下,而浸没式液冷数据中心由于冷却效率高于传统的数据中心25倍,从而单机柜的配电量可以达到50KW以上甚至未来达到100KW。这样的功率密度下,浸没式液冷数据中心的运算与处理效率是传统数据中心几倍甚至几十倍,所以浸没式液冷数据中心天然地适合于高性能运算并需要高带宽的网络支持,服务器端口可以有支持50G/100G及未来200G/400G,而主干应用可以支持100G/400G以及未来800G以上的带宽的应用,甚至不排除未来采用CPO集成式封装的光器件支持1.6T及以上。基于以上的带宽的要求,高带宽应用的主流传输技术主要依靠光纤技术。采用浸没式液冷的数据中心必然与高带宽的网络相配套,所以对布线系统的要求主体需要重点关注于高带宽的光纤布线系统。

注:图片来源于3M

三,可维护性与管理的要求:

浸没式液冷数据中心应用条件高密度是一个重要特征,高密度的条件下数据中心网络路由错综复杂。数据中心的布线系统不仅仅是要满足带宽的要求,同时布线系统也是对整体数据中心网络路由起到管理的作用。数据中心布线系统的管理主要涉及到IT设备间的系统路由的标识、设备新增移动时的系统管理,设备维护及测试检修时的系统管理等多个方面。浸没式液冷数据中心的机柜与传统数据中心机柜不同,浸没式液冷机柜为了防止冷却液的挥发,通常是采用封闭式的箱体。在这样的条件下需要用更创新的布线系统实现系统的可维护性与管理的要求。

注:图片来源于3M

一,布线材料与冷却液的化学不兼容的挑战

不兼容性会导致产生化学反应,使得布线产品的从材料的角度产生变脆、熔胀等问题,或布线产品的材料与冷却液恶化,或产生燃烧,高压分解等不可预测的问题,这将是有别是传统布线系统所没有的挑战。

二,光学性能的挑战

光纤布线系统浸没于冷却液中,光纤端面可能流入冷却液,而冷却液体与石英玻璃材料的光学折射率不同,导致衰减过大或根本无法正常通信,而之前分析中浸没式液冷的数据中心通常应用于高性能计算等带宽要求高的场景,这种场景对于光学性能要求更高,这将是面临的另一个挑战。

三,系统管理上的挑战

所有布线系统安装于封闭式液冷柜内,布线系统又浸没于冷却液内,如何才能便利地高效地对系统路由进行维护与管理将变成一个大问题,如果处理不当,将可能导致系统宕机并产生重大经济损失。

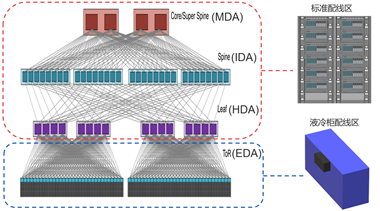

数据中心布线系统与网络结构直接相关,数据中心的布线系统的管理核心在于核心网络Core Network位置的MDA主配线区域的管理,同时对于数据中心Spine主干网络的汇聚层IDA中间配线区或接边缘网络Leaf交换机位置的HDA水平配线区,当此处采用交叉布线管理时,此处可以仍然采用非浸入式的管理,保持管理的便利与效率。而液冷柜内的网络主要是处于TOR架构的EDA区域,此处需要采用特殊的布线系统进行连接与管理,总体的架构的图示如下:

系统架构图

系统平面图展示

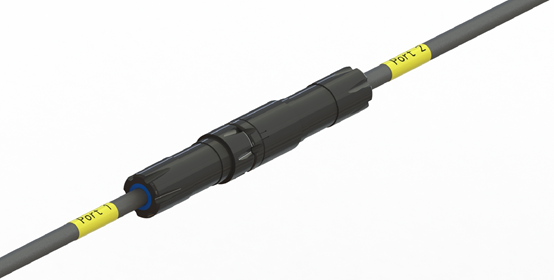

在高性能计算的场景下,采用光纤系统显然是保证带宽要求的最佳系统,当然在传输速率不高以及传输距离5米以下的情况下,DAC直连铜缆也可以实现部分目标,但柜内的数据中心应用不仅仅是TOR的短距离连接,还有部分布线是从TOR交换机上行的线缆,这部分线缆距离比较长,DAC无法满足要求。而如果采用传统的光模块加光纤跳线产品的配合的情况下,如果要达到理想的高带宽以及高的交换机端口密度,难于保证光模块端部的光纤连接在冷却液进入后的正常光通信。基于以上分析,新一代基于浸没式液冷的AOC产品可以实现带宽与传输距离的要求,在AOC上采用创新的专用防水连接即保证的维护管理的便利性,同时在光收发器内部采用专用的防水设计可以保证AOC在整体光学通道上与冷却液的隔离,从而不会影响高带宽状态下的通信。

液冷柜专用AOC配线系统

液冷柜专用AOC上的Mini-RMC防水连接

上图为创新的防水AOC的解决方案,每个液冷柜可以安装上AOC的配线系统,每根液冷柜专用AOC上安装有Mini-RMC防水连接器,此连接器可以达到IP67级的防水,AOC可以支持单模或多模多芯2-16芯光纤的应用,达到100G/200G/400G的应用,未来可以扩展到800G。Mini-RMC配合专用配线槽可以灵活安装于液冷柜内部或机体侧面,应用时不用插拔AOC两端浸在冷却液侧的收发器,有需要时可以快速通过打开每根AOC中间的Mini-RMC连接器进行管理、维护与检测。

关于我们文章前面提及的材料与冷却液的兼容性问题,需要做浸没液冷的材料兼容性验证,以3M的冷却液为例,高沸点单相液体(FC-3283)采用80度下浸泡48小时后的兼容性模拟真实条件下的测试,低沸点两相液体(FC-72)采用索式提取器萃取48小时后的兼容性模拟极端条件下的测试,所有经过实验室测试验证后的布线系统,才能应用到浸没式的液冷数据中心内。

趋势与展望

浸没式液冷数据中心是数据中心基础设施的重大创新,解决了数据中心长期以来单机柜功率无法几何级提升的难题。当前来看浸没式液冷的总体成本比传统数据中心要高,但在部分高性能计算以及超低PUE目标的催生下,这将成为数据中心技术发展的路线之一,而且市场年均增长率超过30%,是快速发展的潜力市场。与之相配套的浸没式液冷数据中心的布线系统需要根据环境要求进行配套创新,长期来看,基于AOC技术的布线在解决上述三大挑战后,将成为浸没式液冷应用的优先选择的对象,德国罗森伯格以Mini-RMC的连接技术为基础进行系统化创新并结合防冷却液的AOC定制化开发将为未来浸没式液冷数据中心布线系统的应用铺平道路。

本文地址:http://www.iccsz.com//Site/CN/News/2022/04/22/20220422012003557330.htm 转载请保留文章出处

关键字: 浸没式 液冷 数据中心 光纤

文章标题:浸没式液冷数据中心布线系统应用技术分析(下)

2、免责声明,凡本网注明“来源:XXX(非讯石光通讯网)”的作品,均为转载自其它媒体,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。因可能存在第三方转载无法确定原网地址,若作品内容、版权争议和其它问题,请联系本网,将第一时间删除。

联系方式:讯石光通讯网新闻中心 电话:0755-82960080-168 Right

- · Comcast部署了业内最长商用空芯光纤线路

- · RVA:未来五年美国光纤宽带市场将出现创纪录的增长

- · 诺基亚为微软的数据中心网络提供数据中心交换产品组合

- · 锐科激光:公司全资子公司武汉睿芯特光纤自供率高于70%

- · 10个国家数据中心集群带动投资超1900亿

- · 10个亿!中卫数据中心集群2022年三大投资项目发布

- · Horizon 完成对 Consolidated Cooperative 的商业光纤业务的收购

- · 5G前传技术方案可行性分析和应用策略研究

- · Everstream融资超10亿美元 用于10个州的网络扩张

- · “东数西算”助推光纤升级换代,G.654.E光纤迎来高速增长

- 设置首页 | 光通讯招聘 | 企业搜索库 | 广告服务 | 联系我们 | 保护私隐 | 公司介绍

Copyright ? 2009 ICCSZ.com Inc. All Rights Reserved. 讯石公司 www.iccsz.com版权所有 粤ICP备12008183号-1