大型数据中心内的网络“甜点”——阿里巴巴自研DAC之路

DAC(Direct Attach Cable),即直连线缆,在ICT领域有着非常广泛的应用,常用于各类IT设备的计算、存储、网络等高速接口短距离互联,也通常以其本质相称——高速铜缆。

作为数据中心物理网络中的“第一段高速公路”,DAC在国际大型数据中心内已有10多年的大规模使用历史,国际大型数据中心几乎不使用AOC(Active Optical Cable,即有源光缆)。2019年前,国内数据中心的应用状况恰好相反。

2018年,阿里巴巴开启自研DAC之路。自2019年至今,国内各大数据中心累积使用DAC的数量已远超500万根,仅阿里云数据中心,在2020年就已达到百万级部署规模。

阿里自研DAC的应用和落地,只是整个阿里云基础设施进步和创新的众多方面之一,但却体现了阿里云基础设施整体协同创新、务实求稳的思路。

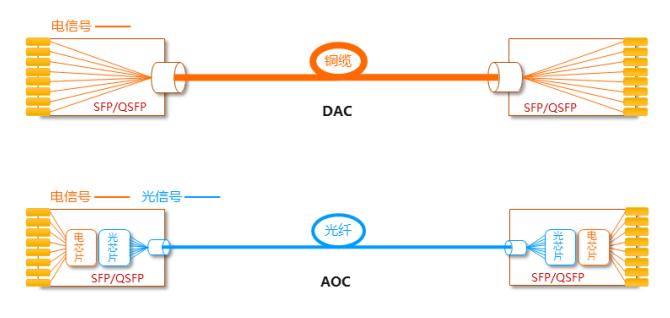

图1:商用DAC(左)和AOC(右)

Q&A

01 数据中心物理网络互联

首先我们看一下数据中心内物理网络高速互联链路的情况。

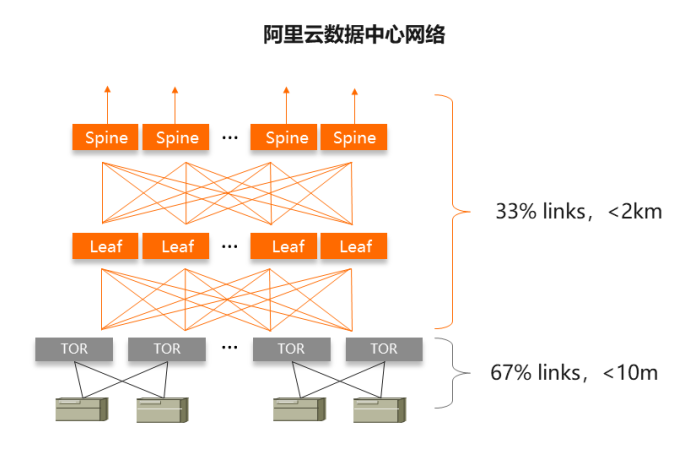

图2:数据中心网络链路概览

在阿里云数据中心网络典型3层CLOS架构下,集群内用于Spine和Leaf以及Leaf和TOR之间互联的网络链路长度一般在2km以内,其中Leaf和TOR之间的互联长度通常在100m之内。这些需要短距和长距光模块连接的链路数量,占到整个集群内总物理链路数量的1/3;而从服务器网卡接至TOR的链路长度通常在10m之内,但是其链路数量则占到了总物理链路数的2/3,通常使用DAC或AOC来连接。

一、DAC和AOC的异同

图3:DAC和AOC电/光通道

AOC和DAC两者在两端的模块封装上采用相同外形和电界面,如SFP、QSFP等各种标准,确保和系统侧(交换机、NIC等)的标准接插。

AOC的模块中包含了电、光转换芯片,基本功能如CDR、Retimer/Gearbox、Laser、PD等电光器件,系统侧的电信号调制到光信号上进行传输。

DAC则仅仅是无源铜媒介,包括模块中直接将高速差分同轴线(twinax cable)焊接起来并外加屏蔽层和外被层作为成缆(cable assembly),电信号从端到端直接传输。

二、AOC的优势和问题

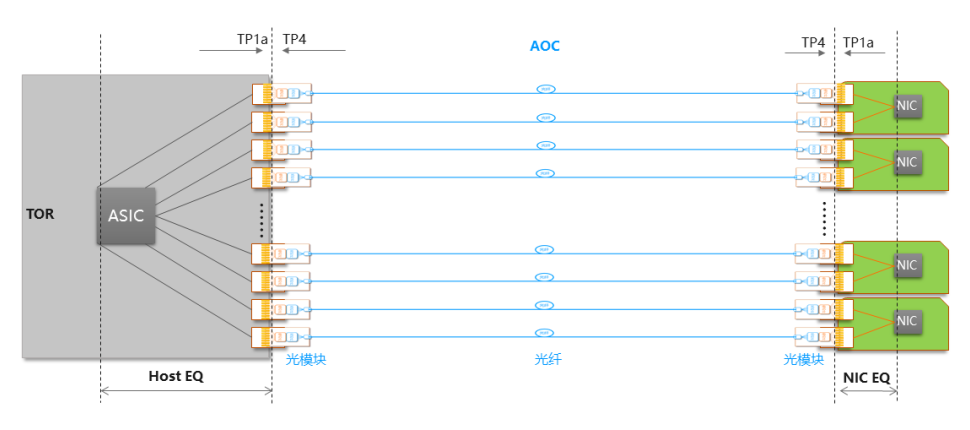

图4:AOC在“黑盒”交换机下与NIC互联

1. 标准界面,即插即用。针对AOC光模块的应用,以可插拔模块和系统端口处为一致性目标点(TP1a和TP4),因此,在交换机“黑盒”时代,只要交换机所有端口和光模块都满足TP1a和TP4的电信号规格,AOC便可以即插即用。中间光信号的传输在模块之间闭环,系统用户也无需关心。

2. 光纤支持更长连接距离。众所周知,光纤的单位长度损耗极低,可支持的传输距离远超铜缆。

三、DAC的优势和问题

对IT设备的用户和运维者来说,DAC相比AOC有两个非常直观的优势:成本和功耗。

以2019年25G DAC和AOC为例:

1. 成本低:DAC的成本是AOC的约1/5。

2. 功耗低:DAC无源,零功耗;25G AOC功耗大约在1~2瓦/根。

DAC还有相比AOC拥有更高可靠性和更低延时的优势,在大规模部署和对时延敏感型的业务中会有较明显的体现。DAC相比AOC在浸没式液冷环境中有更强的适应性(无需考虑光模块对液体敏感的光电器件的密封处理)。

四、DAC未规模化使用归因

2019年之前,DAC在国内数据中心未被规模化使用的原因有两个:

1. DAC在网络“黑盒”设备下的运营问题:在使用商业交换机的时代,物理网络中从TOR到服务器网卡,一路黑盒,无法做到包括DAC在内的“端到端”调试,而最好选用界面信号相对标准化的AOC即插即用。如果要使用DAC,则面临“黑盒交换机”和各种类型网卡的组合适配工作在整个生命周期内都可能无法收敛,显然对追求“稳定”和“运营边际效应”的数据中心网络运营是无法接受的。

2. DAC长度无法满足各种IDC环境部署需求的问题:DAC因直接透传高速电信号,所以长度受限于电信号损耗预算,通常在10Gbps下不超过7m,25Gbps下不超过5m,56Gbps下不超过3m,112Gbps下不超过2m,而AOC则通常可以做到最长30m到100m。

在国内大型互联网公司的数据中心快速发展的早期,以租用机房为主,机柜功耗上限、机房散热能力、机柜布线通道等限制条件各不相同。TOR通常要跨多个机柜来接入服务器,并且还要照顾不同出线方向的服务器,造成服务器至TOR的接入距离在大部分场景下都超过DAC能提供的最长距离,只好选用更长的AOC来支持。

这一切,随着2018年阿里云基础设施开始进行数据中心网络自研、IDC机柜自研及超大规模自建机房的投入运营发生了改变,在这场盛宴中,阿里把DAC这盘“甜点”端上了台前。

2018年开始,阿里开启白盒交换机+自研DAC的研发,确立了“以终为始”的原则:以最终大规模部署时的网络稳定性、运营效率为导向进行总体设计。虽然“黑盒”下也存在DAC使用的技术可行性,但“白盒”才给大规模运营提供了根本保障。

图5:DAC在“白盒”交换机下与NIC互联

DAC互联场景下,实际上两端芯片(MAC到MAC或者PHY到PHY)之间是一个完整的电通道。

TOR交换机+DAC+NIC每一种连接组合的总loss不同,需要TOR ASIC针对每一种loss设置合适的Tx EQ均衡参数来确保接收端的BER满足无差错传输的需求,组合情况非常多。

交换机“黑盒”下,如果使用DAC,问题就来了:

首先,新业务需求(网卡、线缆)要依赖设备厂商提供端口参数更新并在线升级,这对网络运营的稳定性和规模部署效率是极大的挑战。

其次,若妥协使用Link Training模式,可以让99%以上的链路工作,但是在百万级别规模的链路数量里,这个可靠性量级会给运维带来沉重的负担。

阿里云自研白盒交换机和自研DAC是如何解决上述DAC应用问题的?

1. 白盒下收敛端到端loss组合。阿里在交换机硬件设计时便考虑了交换机端口和内部链路的使用规划,设计用于下联服务器的端口通道loss较小且loss分布范围较窄,并且同时在自研DAC的定义中,基于IEEE 802.3相关规范,针对不同长度的DAC,通过使用合适的线径,收窄自研DAC的总体loss范围。最后根据网卡通道的设计特征,在总通道loss计算和仿真中预留合理和足够的网卡通道loss budget。这些设计,并不用付出额外的成本代价。

2. 白盒下选用固定均衡参数。基于以上设计,总体互联通道loss的收窄和可控,使得在实际中可以选用一套固定的均衡参数就可以让所有互联组合都能得到裕量足够的BER性能,这套参数并不是针对每种组合都是最优的参数,但是BER足够,且链路稳定可靠。从而避免使用Link Training模式,让大规模网络运营具备边际效应。

至此,这只是DAC规模化部署设计中最基本的一部分,如何快速落地、让DAC在IDC真正用得“爽”,还要解决机柜集成、交付、运维的问题,这是更关键的一步。

03 基础设施协同创新 铸成阿里DAC规模部署之路

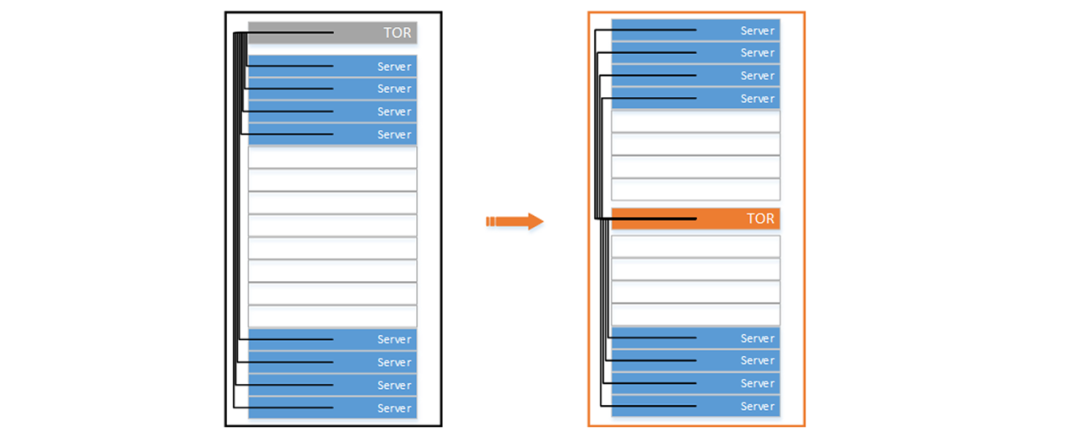

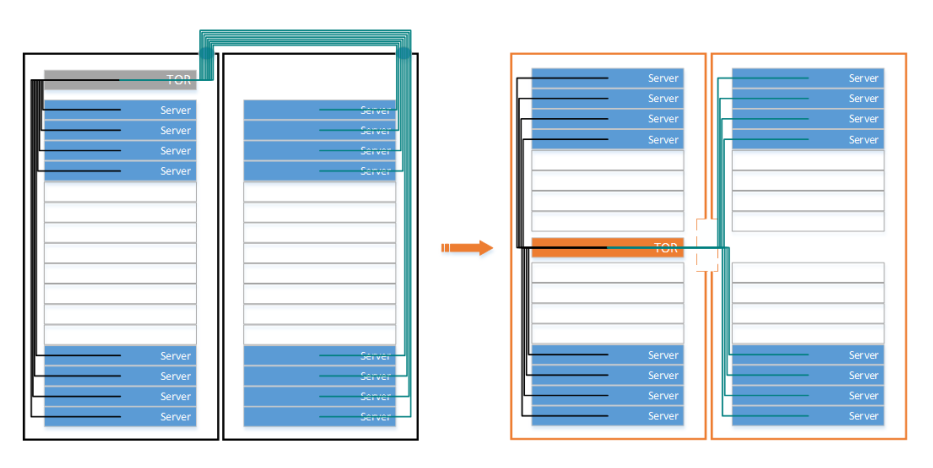

就在2019年阿里数据中心大规模成功部署DAC之后,业内迅速出现了一个新词——MOR(Middle of Rack),用来戏称阿里巴巴将TOR(Top of Rack)中置的做法。这个戏称在某个层面却很形象地说明了阿里在IDC机柜级别做出的一些独具匠心、因地制宜的创新。

阿里云基础设施通过整体设计来克服DAC固有的种种短板,让DAC的可规模应用转化为稳定性、能耗、成本、交付和运营效率等方面的整体收益。

首先,打破常规,TOR中置。TOR不一定必须放在Top。阿里将接入层交换机置于服务器机柜中间U位,单柜内交换机到最远服务器的布线距离就缩短为了机柜高度的一半,单柜内最长仅需不超过2m。阿里第一代自研交换机甚至设计了后向前、前向后两种散热风流方向,来支持不同出线方向的服务器,从而做到机柜内同侧布线,保证DAC长度需求最小化。后续的演进中,阿里已经将服务器的出线方向统一为前侧,交换机型号归一。

图6:传统机柜(左)TOR顶置vs阿里自研机柜(右)TOR中置

其次,因地制宜,机柜创新。因为不同业务类型的服务器配置不同,除单柜外,仍然会有交换机跨两柜接入服务器的需求。因此在交换机中置的同时,全新的机柜设计将跨柜理线的通道设计在了机柜中部(传统机柜跨柜理线需要从柜顶的弱电孔穿出穿入)用于穿线。这样的话,跨两柜的交换机到服务器线缆最长需求2.5m便可以满足;还有一点考虑:2.5m的长度需求在56G-PAM4可以轻松满足,甚至未来112G-PAM4速率也有机会做到。

图7:传统机柜(左)双并柜布线vs阿里自研机柜(右)双并柜布线SERVER

第三,布线标准化,助高效集成交付。将DAC从0.75m开始到2.5m之间以0.25m步长定义DAC长度规格,将中置交换机到机柜各个U位服务器的布线规则进行标准化定义,线缆长度刚刚够,而无需额外的弯折和盘线,使得整机柜集成和交付的效率大大提升,同时也尽量避免DAC过度弯折带来的信号完整性性能劣化。

第四,DAC自研创新,解现场运维之忧。考虑到IDC运维习惯了多年的AOC较细、较软的布线和运维体验,阿里在自研DAC的设计中特别使用了尼龙编织外被取代传统的PVC材质的外被,使得第一代25G DAC的弯折半径和柔软度较标准商用DAC大幅提升,成功帮助IDC现场运维从习惯已久的AOC过渡到DAC。

图8:阿里自研25G DAC(左)和200G 1分2 DAC(右)

随着自研交换机和DAC,以整机柜集成的形式在阿里云数据中心快速规模化部署,阿里云数据中心DAC在2019年起的一年多时间内,率先达到了百万量级的部署规模。

04 开放共赢 结出国内DAC应用累累之果

2020年,在阿里巴巴数据中心部署DAC累积百万规模、运营一年之后,由阿里巴巴牵头,和腾讯、百度等国内大型数据中心用户合作,联合立讯、兆龙等国内DAC厂商代表,在ODCC发布了《下一代数据中心高速铜缆技术白皮书》。

《白皮书》

详细阐述了DAC在数据中心高速互联中的应用技术,以及从25G-NRZ至56G-PAM4演进的方案。

阿里巴巴以自己的大规模部署、运营结果,给国内用户们带来了DAC应用的最佳实践经验和信心。随后几年,越来越多的国内大型数据中心都陆续将DAC作为物理网络“第一段高速公路”的首选,越来越多的合作伙伴也相继进入DAC的研发、制造、供应和集成。

从2019年至今,国内数据中心部署DAC的数量已累计超过500万根,而这背后,带来的是每年数以亿计的成本降低和数千万度电力的能源节约。

DAC在数据中心内的大规模部署使用,带来的并不只有最直观的成本和能耗收益,还有对数据中心网络架构设计、演进、业务性能的影响。如果从整个云基础设施的角度来看,后者甚至具有更重要的意义。

一、与业务松耦合,让网络轻松演进

1. 网络追求单GB成本红利,演进较快。数据中心网络商用芯片的带宽基本上维持着每3年翻一倍的演进速度,数据中心网络也会在第一时间同步演进,以追求单GB网络带宽成本的下降红利,以及新特性的应用。

2. 业务长尾且多样,迭代不同步。在同一个数据中心网络内,同期通常会有不同速率的业务接入需求,比如在200G网络下,主力接入是50G服务器,但同时仍然会有25G和100G服务器业务的接入需求。

3. 利用多种形态的线缆,使数据中心网络的演进与业务迭代松耦合。DAC的使用,非常容易实现各种特殊形态线缆,因为不同形态的DAC在主体上都是使用相同的高速裸线、制造工艺。DAC提供的低成本、通用性、灵活性、快速交付等特性,能够高效地支持不同速率的业务接入,让数据中心网络能够轻松、快速地演进获得带宽红利和新特性。

阿里云数据中心100G网络架构中,采用25G和100G (NRZ)两种直连DAC,TOR则对应有25G和100G两种型号。

阿里云数据中心200G网络架构中,进一步将TOR收敛为一款设备,而使用Breakout形态如200G 1分2,100G 1分4,50G 1分2等多种DAC线缆,来支持从25G到100G(PAM4)不同速率服务器接入。网络则快速从100G迭代到200G。

未来阿里云数据中心网络的迭代和演进,也将受益于此。

二、稳定性提升,延时降低

1. 在普通风冷环境中,DAC的故障率同比AOC降低1个数量级以上。由于DAC零功耗,不含有电、光芯片等有源器件,不存在因激光器老化、半导体电应力等导致的失效因子。在业务运行中DAC体现了非常高的稳定性,网络运营轻量化,用户网络体验“丝般顺滑”。

2. 在浸没式液冷环境中,DAC更是体现了简单、可靠的特点。DAC内不含有激光器、光波导等对液体敏感器件,不必采用如光模块所必须的密封工艺,从而极大降低了相应的成本,提高了可靠性。阿里数据中心DAC通过对材料选用、线缆信号完整性性能设计,采用一款DAC同时支持风冷和浸没式液冷环境。

3. DAC提供极低的延时性能。DAC和光纤线缆本身均会有大约5ns/m的传输延时,但是光模块则因重新时钟恢复(CDR),甚至需要基于DSP的信号均衡技术,引入了额外的信号延时。在AI计算、资源池化等场景下,延时需要格外的控制。PCIE Gen6在64G-PAM4的速率下物理层协议中为了控制延时仅仅留了10ns以内的FEC延时开销预算,而光模块DSP-based re-timer芯片就会带来几十纳秒的延时(收+发)。

三、节能减排,降本增效

能耗和采购成本的降低,是从AOC切换到DAC后带来的最直观的收益。尤其是当匹以数据中心百万级别的使用数量时,数字更令人吃惊。

以100万根25G直连DAC为例:

OPEX:每年节省的电力消耗为>1千万度;

CAPEX:每100万根25G DAC节省>1亿元。

此外,DAC无需建立如光模块运营中所需的对激光器、模块温度等监控所需的系统,无需关注光纤端面洁净度等现场问题。在数据中心内服务器部署规模爆发式增长的同时,DAC的应用帮助IDC现场运维、数据中心网络运营效率明显提升。

06 展望未来

DAC以铜为传输媒介,本质上决定了无论物理网络通过提高单通道速率还是增加并行通道数量的方式来升级链路带宽,DAC的应用都会受到严重挑战。“更不幸”的是,这两种方式往往是同时或交替进行的。

一、挑战:越来越短,越来越粗

铜缆传输线的损耗在3~6dB/m这个级别,随着单通道速率的不断增长,能支持的DAC长度将会越来越短。如果能支持的最长长度达不到1.5m~2m,那就失去了DAC应用的大部分意义。

DAC中每一路铜传输线的直径在毫米级别(光纤则在微米级别),4通道→8通道→16通道的scale out使得DAC的直径几乎成倍地增加。

所以在网络速率和带宽不断提升的过程中,DAC在机柜内布线、可连接长度都有非常大的挑战。

二、DAC的未来

随着物理网络单通道速率迈向224Gbps,铜媒介电通道面临着非常大的挑战。但是在高级Serdes技术的加持下,在材料和工艺不断进步中,使用DAC来满足数据中心超短距网络互联仍然是可实现且意义重大的。

1. 材料和工艺演进:高速线缆的材料(包括绝缘介质材料和导体材料)性能以大约每三年20~30%的速度提升,而信号速率则是每三年翻一倍。当前的研究中,一些新的DAC材料工艺和技术也在不断地涌现,例如在不降低铜导体直径的情况下,通过新材料和工艺降低绝缘层的厚度,使得总体线径较小;还有比如通过成缆方式的改变,在同样线径下使得线缆更软更易弯折。

2. 新的应用需求:随着AI计算的迅猛增长,AI训练集群内的互联扩展需要高带宽、低延时。另外计算、存储资源池化和扩展,也在提出对低延时互联技术标准化的需求。DAC的高稳定、低延时的特性可以很好地满足这些领域的需求。

3. DAC长度之上的潜在方案:从通信的逻辑上看很简单,“电中继”或者“电转光”,满足超过无源DAC长度极限的需求。

有源铜缆。通过在DAC的模块中加入Re-driver或Re-timer,来“中继”电信号以达到延长高速电信号传输距离(变长),或同等距离下减小线径(变细)的目的。其成本和功耗介于无源DAC和有源AOC之间,在一定的速率范围内是个不错的选择。但是随着速率上升到112G-PAM4以后,需要有CDR功能的re-timer(甚至DSP-based),后者则又带来和光模块相当的传输延时和功耗代价。

Direct-drive光模块。其模块中不使用CDR(且不使用DSP-based均衡器)从而同比大大降低了传输延时,代价是强依赖于链路两端的芯片来提供对信号的补偿和均衡,两端设备内的通道损耗预算被缩减。当前业内的一些厂商在进行基于112G-PAM4速率的Direct-drive光模块研发,生态处于早期阶段。

DAC技术,只是数据中心物理网络互联技术中的一个小部分,其所带来的成本、能效、稳定性、网络性能方面的贡献是非常明显的;同时,其局限性和挑战也一样明显。

面对未来高性能、可预期数据中心网络的发展需求,我们需要的,一定是基础设施整体的创新。

本文地址:http://www.iccsz.com//Site/CN/News/2023/02/16/20230216114854223742.htm 转载请保留文章出处

关键字: DAC 阿里巴巴 数据中心

文章标题:大型数据中心内的网络“甜点”——阿里巴巴自研DAC之路

2、免责声明,凡本网注明“来源:XXX(非讯石光通讯网)”的作品,均为转载自其它媒体,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。因可能存在第三方转载无法确定原网地址,若作品内容、版权争议和其它问题,请联系本网,将第一时间删除。

联系方式:讯石光通讯网新闻中心 电话:0755-82960080-168 Right

- 设置首页 | 光通讯招聘 | 企业搜索库 | 广告服务 | 联系我们 | 保护私隐 | 公司介绍

Copyright ? 2009 ICCSZ.com Inc. All Rights Reserved. 讯石公司 www.iccsz.com版权所有 粤ICP备12008183号-1