800G MSA白皮书解读(上)

本文转载自微信公众号“光通信充电宝”,作者冯振华博士,经允许略作删改。

3月12号,800G可插拔光模块MSA工作组发布了业内第一份800G MSA白皮书,一直没时间看,今天找出来看看,把要点给大家分享一下。先来谈谈这个MSA组织吧。

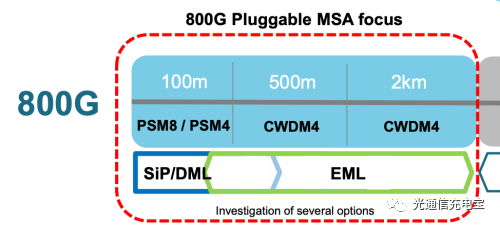

800G pluggable MSA的发起者主要是中国和日本公司,包括、光迅、中国电信技术实验室、H3C、海思、华为、立讯精密、住友、腾讯和山崎,当然后来陆续还有其它公司加入。目标是定义面向数据中心应用的短距800G传输用的可插拔低成本光模块,包括8X100G与4X200G两种规范,传输距离包括100m,500m,2km,如下图所示。

图1. 800G MSA的研究范畴

目前业界有部分观点认为800G的传输需求将在2021年出现,但直到2023年市场开始走向成熟。对应的还有个美国通信巨头博通、思科牵头成立的QSFP-DD800MSA光模块工作组,推动QSFP-DD格式的800G光模块和相关连接器标准化。

白皮书的题目叫《用800G光模块使能下一代云和AI》,很有华为的味道,当然事实上参与单位还包括腾讯、百度等互联网大佬,(可惜我司暂不在其中啊)如图2所示。全书共16页,分为六章。行文脉络大概是这样的:

1、新应用(云计算,AI应用)催生了更高互连带宽的需求,业界需要更高速的光模块,如800G;

2、数据中心的架构,不同位置交换机对带宽的要求;

3、SR互连场景的需求,8x100G的应对方案技术分析;

4、FR互连场景的需要分析,4x200G技术可行性,重点技术;

5、应对DR场景的潜在技术方案;

6、总结与展望。

图2. 800G MSA主要推动单位

1. 背景介绍-800市场即将到来

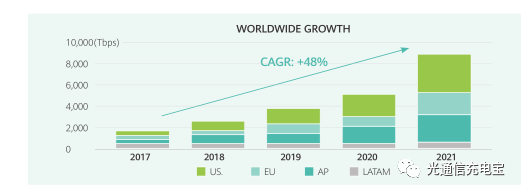

白皮书指出,根据相关研究,诸如AR/VR,AI和5G的新应用将会产生越来越多的流量,并且呈指数增长,这将导致更大带宽和更多连接的需求,如图3所示,全球的互连带宽容量在最近四年仍将快速增长,复合增长速率高达48%。

图3. 全球互连指数

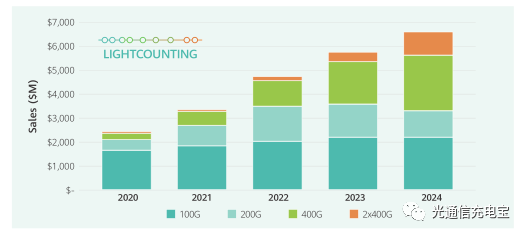

与需求相对应的市场,也反映了这一趋势。如图4所示,根据light counting预测,未来5年数据中心市场400G光模块将快速增长,到2022年左右将出现2x400G或800G的市场。按照Lightcounting 市场研究公司的CEO, Vladimir博士的话说就是,云数据中心的运营商在2023~2024年将会部署800G光模块来应对不断增长的网络流量,这其中大多数的光模块将是可插拔的,并且也可能看到采用共封装(co-packaged)的模块。

图4. 数据中心光模块市场年销售额预测

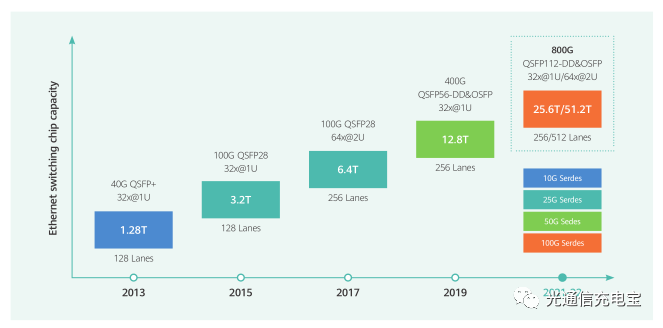

由于在交换ASIC芯片领域,两年容量翻一倍的摩尔定律尚未失效,云数据中心的架构将受到扩容的挑战。目前商用部署的以太网交换机容量为12.8Tb/s,不过1年后就要面临被25.6Tb/s的替代。交换机的容量演进路线如图5所示,这将给高密度光互联带来巨大的压力,因为不是所有的光电器件都能像CMOS工艺那样每两年集成密度增加一倍,这是由于不同的器件,它的设计和制造方法不同所决定的。

图5. 数据中心交换芯片容量演进规律

在过去的几年里,基于NRZ直接探测的100G短距光模块大出风头,承载了大部分的云服务快速增长的流量。自从IEEE在2011年3月启动了400GE相关标准的研究,在2020年将会迎来400G 光模块的规模部署,并且明年的需求更加强劲。图4反映了这一增长趋势。值得注意的是,在应用初期,400G模块主要是用于DR4场景下传输,速率4x100G,距离达500m,以及FR4场景,2x200G速率,距离长达2km,并没有真正用到400GE MAC功能。同时,还注意到IEEE可能在短期之内并不会将800GE光口标准化,至少在近两年内是完不成8x100GE或2x400GE高密度互连的800GE标准的,但到那时800G实际需求已经出现,因此需要业界来制定规范,实现不同厂家800G产品互连互通。

2. 数据中心架构

一般来讲,面向的应用不同,数据中心的结构及流量特征可能不同。比如,面向外部客户提供XaaS类型服务的数据中心中的主要流量更可能是南北向的服务器到客户端的,这样的话,数据中心规模在地理上可以更集中。而如果是面向内部需求的云计算或存储为主的数据中心中,流量更倾向于东西向服务器与服务器之间流动,这一般需要集中超大型数据中心资源。甚至尽管应用场景类似,运营商依然可以根据自家喜好来选择基于PSM4或CWDM4的光互连方案。这就导致了数据中心架构和技术的多样性。

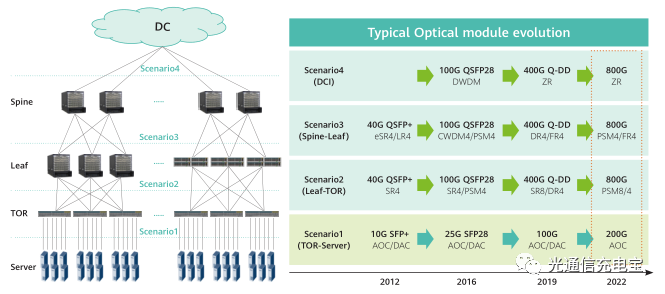

常用的数据中心架构至少有两种。 下图给出了典型的数据中心架构(3层)及其交换速率演进路标。不过通常的数据中心会比图中的设备更多,架构会显得更加庞大和复杂。每一层之间会考虑3:1左右的收敛比,如一个Spine交换机下面可能会连接3个Leaf交换机,以此类推。在Spine层之上需要通过ZR类型的相干光互连方案来实现与其它数据中心的互联(也就是DCI场景)。800G接口速率出现的标志是,当sever和TOR交换机之间的速率达到200G的时候,TOR到Leaf之间以及Spine层就不得不采用PSM4 4x200G的扇出结构了。

图6. 常见3层数据中心架构及光互连速率演进

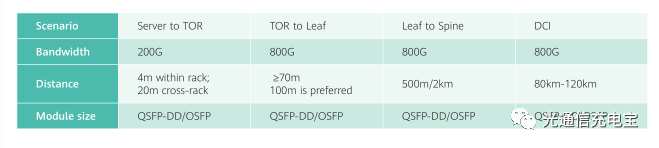

这里的TOR,Leaf,Spine交换机其实就分别对应着我们在网络中经常说的接入层,汇聚层和核心层了。通常对于典型的数据中心网络(DCN),如果部署200G带宽的服务器,就得具备800G的网络连接带宽,但也可以根据数据中心建设成本预算,在数据中心提供服务的能力(即带宽、传输距离等资源)上做出一些折中考虑。如表1,给出了数据中心网络中不同层级对带宽和传输距离的要求,并给出了推荐的光模块封装尺寸要求。

表1. DCN不同层对带宽和传输距离的要求

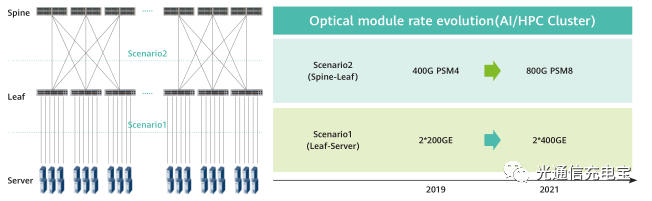

考虑到最近兴起的AI应用大量的计算需求,在一些面向AI应用的超级计算机集群或AI数据中心中,人们通常会采用两层的交换架构,如图7所示。这是因为考虑到AI计算的特征,不需要层与层之间的流量汇聚,每个服务器的流量已经非常大,因而直接对应一个交换机接口,独享带宽资源。可见,这种AI或超算数据中心网络中,流量特性与常规的数据中心不同,它主要是大颗粒流量业务,不需要频繁地交换。

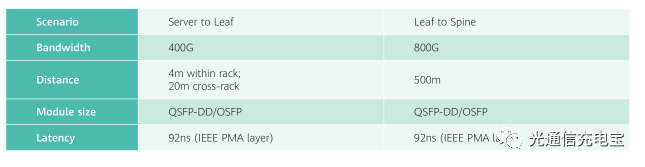

图7. AI/高性能计算数据中心网络架构及速率演示

这种二层数据中心网络,由于没有层之间的流量汇聚需求,如果部署400G的服务器,才需要800G的网络互连带宽。相比于传统的三层交换数据中心网络,这种二层架构更方便快速部署,同时也具有更低的延时,非常适用于未来的AI或超算 DCN。表2给出这种DCN具体技术指标。

表2. AI或高性能计算数据中心网络需求

不过,有些小公司或小型云数据中心网络中,Leaf与服务器之间的传输速率可能并不需要400G这么大的带宽,这就需要在具体设计的时候考虑实际面临的应用场景与成本之间的关系。附带谈一谈数据中心建设应该注意的问题吧。在数据中心解决方案中,最应该关注两个因素是可扩展性和成本。当设计一个数据中心时,成本控制和性能的建设标准不能过高或过低。如果用户过度建设,那么将会浪费资源,虽然这些资源可以用来拓展更多的业务。但是闲置的资源能力是很昂贵的,而且当真正需要使用它的时候,这个能力可能成为被淘汰的技术。例如,如果用户建立一个数据中心,预期生命周期为10年,并已经建立了额外容量,以适应未来的增长,但这个能力可能在5年后过时。届时电能消耗、性能和其他功能的进步,可以使数据中心运营和维护处于明显的劣势。

而如果数据中心建设标准较低时也会面临挑战,甚至可能更加昂贵。如果用户的设计规则能力低于计划的要求,在扩建和升级数据中心时,届时将会有一个巨大的资本开支。

正是由于上述的可能存在的数据中心建设过度或不足的问题,因此数据中心的快速扩展、运营便捷以及成本这些重大问题是许多企业优先考虑的事项。企业要采用最灵活的解决方案,通常会选择数据中心托管的模式。数据中心托管运营商允许用户“按需付费,渐进扩展”。用户可以根据需要扩展或减少租用空间,只需支付相关的使用费用就可,这样用户就没有闲置或不足的能力,也就没有了所有设施相关的问题,并能最大限度地提高IT投资的价值。

不过这对于一些互联网大佬都不是什么问题,他们更看重的是数据本身的价值,因而不惜代价重金投入也要自建数据中心及自已提供云服务,把关键资产掌握在自己手里,比如阿里,腾讯,百度,Facebook, google,甚至它们中有的公司还专门有网络基础设施相关研究部门,研究各种低成本高速光互连方案,甚至连光模块都要自研。目的无非就是建设更好的数据中心网络,提供更快速多样的服务,吸引更多的用户。

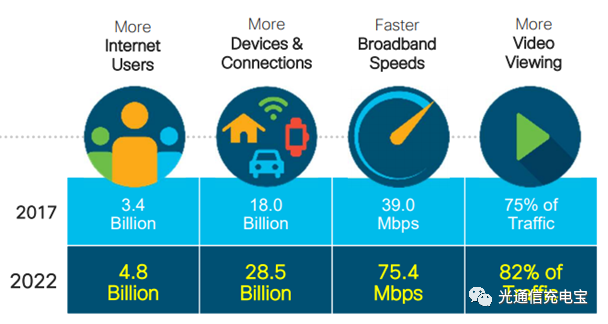

最后,还需要解释一下为什么最近几年数据中心网络如此火爆。这还得从视频说起,下图为Cisco最新的VNI流量预测,指出近几年视频流量在网络中占据越来越大的比例,到2022年预计视频相关的流量将占据整个互联网流量的80%以上。这一点相信大家都不会感到吃惊,因为我们自己每天都是视频流量的接收者和生产者。伴随着视频业务不断兴起的是承载网络架构的变化和流量分布的转变。

随着内容分发网络(CDN)的兴建和数据中心网络(DCN)的下沉,内容,如视频,文件等,这些网络资源被缓存在离用户更近的地方,以提供更低的延时,更快的缓冲速率。这样大部分流量将不再需要经过长距离的骨干网传输,而是就近被终结在中短距的城域网或数据中心网络范围之内。早在2017年就有报告指出中短距的城域网流量已经超过长途骨干网流量了。而数据中心,特别是云数据中心互联(DCI)则是城域网络的最典型应用。因此,近些年关于它的话题火热也就不奇怪了。

图8. Cisco VNI预测流量变化趋势

本文地址:http://www.iccsz.com//Site/CN/News/2020/04/03/20200403030637299488.htm 转载请保留文章出处

关键字: 800G

文章标题:800G MSA白皮书解读(上)

※我们诚邀媒体同行合作! 联系方式:讯石光通讯咨询网新闻中心 电话:0755-82960080-168 Right

- 设置首页 | 光通讯招聘 | 企业搜索库 | 广告服务 | 联系我们 | 保护私隐 | 公司介绍

Copyright ? 2009 ICCSZ.com Inc. All Rights Reserved. 讯石公司 www.iccsz.com版权所有 粤ICP备12008183号-1