阿里巴巴云智能 陆睿:AIGC时代对数据中心光互联的新要求

ICC讯 今年来,生成式AI所需的超算集群开始有云计算服务的形态,成为了云基础设施和光互联产品的新增长引擎。相比通用弹性计算服务器集群所发生的变化。AI训练的云基础设施也在火热的建设中。数据中心光互联技术在AIGC时代发生了什么变化,如何才能更好的适应AI数据中心基础设施的要求。在iFOC 2023上,云智能网络研发事业部光网络架构师 陆睿发表了《AIGC时代对数据中心光互联的新要求》的演讲。

服务器方面,X86为核心的通用计算服务器升级为以GPU为核心的高性能计算服务器,功率更高、算力更强、集成度更高。网络方面,数据中心以太网网络基于RoCE的以太网或者IB的高性能网络,高吞吐、超低时延和高可靠性。

AI超算网络的互联架构包含以太网、Infiniband、NVLink。陆睿对比了三种互联架构之间的有点。以太网成本低、供应丰富,适合多租户共享的超算基础设施;Infiniband相对封闭,适合单一用户建立独享的超算基础设施;NVLink用于GPU之间的高速互联,开销更小,带宽更大,但最大256个节点。

陆睿表示:AI超算网络的光模块选择倾向于选择4通道QSFP光模块,4通道激光器数量更少,有利于可靠性、光模块内部面积更宽裕,设计和制造难度小、光模块功耗更低,系统散热设计更容易。不同数据中心客户根据自己的网络架构特点选择不同的光互联技术方案(Form factor、光电通道数、通道速率)。技术本质基本一样:单通道25G/56G/112G/224G。

AI需要更大的互联需求量,接入方案已经从DAC/AOC线缆变成了光模块。每GPU卡和对应的同带宽光模块数量比例达到1:4~1:6。在Nvidia的DGX H100和GH200的网络架构里加入了NVLink switch架构,进一步提升GPU之间的互联带宽。H100/H800的8卡服务器的对外NVLink带宽是14.4T,每卡和光模块(按400G算)数量比例达到1:9。

AI的发展有更高速率要求,传统云计算市场在发生变化,对更高速率光模块的需求在变缓,基础设施投入进入精细化管控阶段 。目前超算集群性能的瓶颈仍在网络带宽,会成为新一代高速光模块产品的主要需求推动力。

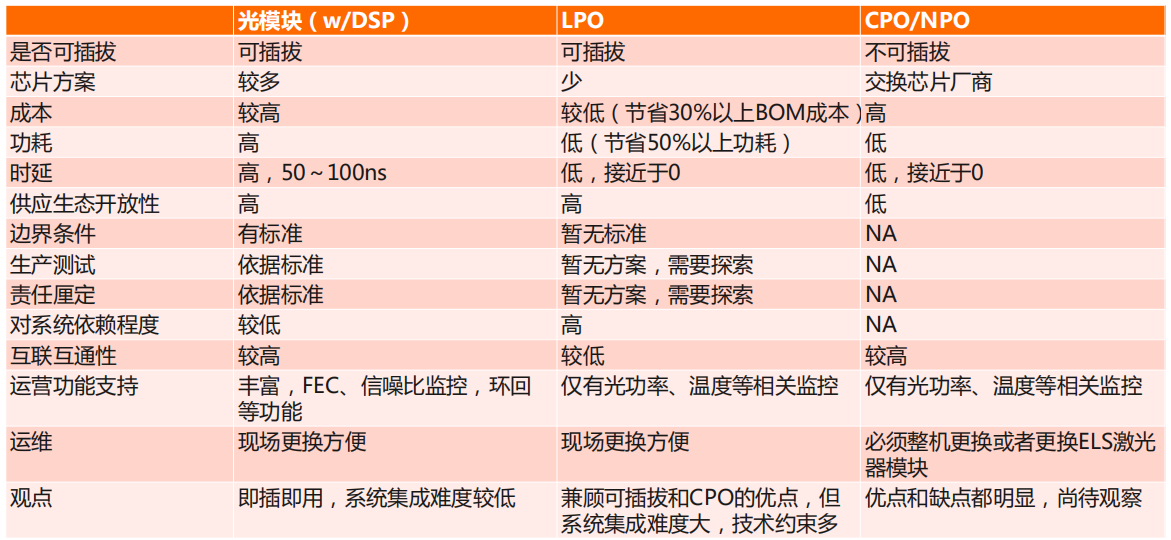

随着交换机Serdes速率和数量的增加,现今,光模块功耗占设备总功耗高达1/3。低功耗、低时延的光互联技术更适合超算,陆睿对比了LPO/CPO/NPO技术的对比和选择,他认为LPO优点是兼顾可插拔和CPO的优点,但系统集成难度大,技术约束多。CPO/NPO优缺点都很明显,尚待观察。

光互联在超算网络中数量多且物理底层,对网络整体稳定性有关键性影响。光互联如何满足更高可靠性要求。陆睿提出研发引入阶段:1.加强光芯片的可靠性认证测试。2.加强光模块在研发和测试引入阶段的可靠性认证测试。批量部署阶段:1.严格执行研发测试——小批量灰度测试——大批量部署的流程;2.加强光模块在批量生产时的可靠性数据监控;3.结合网络监控数据平台、自动化运维监控光模块的运行情况;4.建立优胜劣汰机制,选择可靠性更优的模块技术、型号和厂家。

最后,在持续优化的要求方面,陆睿讲到目前IDC机房供电功率和散热能力设计是为传统云计算X86服务器设计的,不满足GPU服务器的高密部署,低密度部署导致光纤连接距离变长,需要升级浸没式液冷技术或其他效率更高的散热技术。另外还提到新型光纤技术—空芯光纤,空芯光纤可做到3.3ns/m时延,相比普通光纤的5ns/m时延降低了33%,按照3跳交换机、每段链路平均距离50m计算,空芯光纤可缩短约单向0.34us时延,是一个值得期待的技术。

本文地址:http://www.iccsz.com//Site/CN/News/2023/10/27/20231027093708928244.htm 转载请保留文章出处

关键字:

文章标题:阿里巴巴云智能 陆睿:AIGC时代对数据中心光互联的新要求

2、免责声明,凡本网注明“来源:XXX(非讯石光通讯网)”的作品,均为转载自其它媒体,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。因可能存在第三方转载无法确定原网地址,若作品内容、版权争议和其它问题,请联系本网,将第一时间删除。

联系方式:讯石光通讯网新闻中心 电话:0755-82960080-168 Right

- 设置首页 | 光通讯招聘 | 企业搜索库 | 广告服务 | 联系我们 | 保护私隐 | 公司介绍

Copyright ? 2009 ICCSZ.com Inc. All Rights Reserved. 讯石公司 www.iccsz.com版权所有 粤ICP备12008183号-1