IEEE802.3 标准30周年 SC13展览采风

IEEE庆祝802.3标准发布30周年,迈向令人鼓舞的新方向

得益于罗伯特·梅特卡夫(1973年以太网标准的发明者),IEEE以太网802.3 标准协会召开11月全体会议,庆祝他们30年来为以太网标准所做的与时俱进的工作。梅特卡夫博士和以太网标准协会的同事们回顾过去,并详细阐明了未来车联网的远景。这个不会很快实现,但是将会产生很大流量。1GbE 用于双绞铜线(P802.3bp)研究小组、PoDL研究小组(power over data lines)、P802.3br PAR 研究小组(Interspersing Express Traffic)将会是实现车内和车辆之间网络革命的生力军。为什么LightCounting的客户需要关注?400GbE研究小组的一个演讲告诉我们到2023年,只在北美一个地区,就有240Tbps的流量要加到核心网中去,使8000万的联网车辆可以互相交流。(即使你的车由计算机联网,我们希望车主们坐在那里要集中精力!)光核心网络是增长最快的市场。LightCounting一直在关注这个市场。在LC预测报告附带数据库的预览版里有详细介绍。这个预测报告数据库预览版将于12月17日发布。

我们提到400GbE了吗?100G 交换机还没有问世,我们是否太超前了?400GbE研究小组的175位专家不同意这个观点。超级数据中心的建造者们、电信公司和其他运营商(如广电网)想把400G解决方案用于路由器到路由器和路由器到核心网的链路上。LightCounting欣然用实际部署的数据支持了他们的演讲。

步骤一:400GbE研究小组决定他们想要什么样的标准。达成一致意见。这个研究小组共选取了四个目标:在多模光纤100m链路上、在单模光纤500m、2公里和10公里链路上运行400GbE。400G用于电缆的目标没有得到足够的投票,但是现在为时还早,这种情形会变化的。LightCounting在之前的临时特别会议中提出:一个服务器上有1个10GibE端口。4个服务器可以一同接入路由器的1个40GibE的端口。这个研究小组的很多讨论围绕是否要支持这种分离功能。最终分离功能没有采纳。而另外一个要求被采纳:在这更高速率上需要更低的比特误码率:10-13来避免频繁出错。

步骤二:这个研究小组须展现的第二件事是证明使用未来目标的产品要满足以下五个条件:有足够客户、跨厂商兼容性、独特ID、技术上可以实现且在一个合理的成本范围内。有很多工作需要做。这个研究小组转变成工作小组的最早时间是五月份。当他们开始编写标准的时候,那才是有很多挑战的时刻。我们将用16 个通道每个通道传输25G带宽来实现400G传输,还是使用8个通道,每个通道50G带宽来实现?抑或是简单地把4个100G带宽结合在一起,就像之前的40GigE网络那样(把4个10GigE带宽结合起来达到40G传输)这个研究小组是否最后使用一次 WDM NRZ 还是现在是应该跳到更先进调制?LightCounting认为在未来的研究小组会议上有很多新的技术观点和争论。所以,敬请留意!

超级计算展会强调速度、密度和省电

超级计算机展会2013 汇聚11000人,关注在高性能计算、网络、存储和数据分析的最新进展。高性能计算HPC已经不再是关于科学模拟的运算能力了。大数据分析和云计算与HPC融合。现在比以前有更多不同的架构。

Infiniband 经常被HPC互联使用。AOC是长距离InfiniBand连接的实现形式。很多超级计算2013展商都展示和诠释了他们的这些产品。然而超性能计算机能做的更重要的事情是低延迟,且多个处理器可以共享同一个内存(Remote Direct Memory Access)。所以云计算公司在考虑使用RoCE (RDMA over Converged Ethernet)以便可以待在以太网系统中。不管使用这两种方式中的哪一种, AOC将是HPC系统中以这些协议方式传输信号的性价比高和便利的一种方式。

HPC的另外的新功能是处理器和互连的高密度。由于交换机供应商在其面板上安装了QSFP+模块,所以其面板上已经没有多少空间。 EOM是一个解决方案。Arista Networks的创始人Andy Bechtolsheim给LightCounting展示了他们新100GbE线卡,在面板端有12个MPO连接器,另一端是Finisar提供的EOM。这些是12X10G 的连接器,可以在连接器界面分成多路。

专有互连需要最高速度和宽度。Cray 展示了他们的新XC30超级计算机,在其面板上有120个CXP端口,其主板由多个12x12.5G AOC连接。Fujitsu 展示了他们下一代超级计算机主板,使用8个Finisar 新款12x25F EOMs(Finisar 称其BOAs), 与 三个Sparc64 处理器协同工作。

Samtec的客户对他们的FireFly 互连系统很感兴趣。当你嵌入FireFly 互连系统时,可以选择使用铜线链路或光链路。这个链路使用一个普通连接器器,插入主板。12x28G 铜线链路的传输距离是13”,或者以每通道以14G的速度,传输是0.5m。 FireFly EOM,以14G的速度,可以延长传输距离到100m。

一些更新的方法确实使布线降低到最少。Clustered Systems Company 演示了一个高密度机架,通过PCI-Express ,将高达260个的Intel Xeon 处理器与一个正交铜线背板连接。若是需要,将会使用InfiniBand来连接多个机架。Numascale 有一种技术,可以用不长于1.5米的线,来连接216个服务器(10,000核),每个服务器的内存是240GB。这个共享内存结构的意思是单个Linux程序的实例能以虚拟的形式查看所有可用的服务器和所有内存,没有间断。

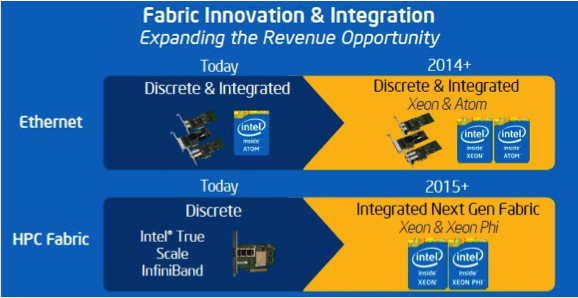

最后,Intel 告诉我们他们打算把以太网网卡和Infiniband卡整合到下一代Xeon 服务器 和 Xeon Phi协处理器中。10GbE 将会明年整合进去。下一代InfiniBand卡会在2015年及以后的时间整合进去。将要推出的Xeon Phi 协处理器,也叫做Knights Landing,将要使用Cray HPC 互连控制器,它有100Gbps网络互连规格 和32个第三代PCI-Express通道。

本文地址:http://www.iccsz.com//Site/CN/News/2013/12/09/20131209084348534600.htm 转载请保留文章出处

关键字: IEEE802.3

文章标题:IEEE802.3 标准30周年 SC13展览采风

※我们诚邀媒体同行合作! 联系方式:讯石光通讯咨询网新闻中心 电话:0755-82960080-188 debison

- 设置首页 | 光通讯招聘 | 企业搜索库 | 广告服务 | 联系我们 | 保护私隐 | 公司介绍

Copyright ? 2009 ICCSZ.com Inc. All Rights Reserved. 讯石公司 www.iccsz.com版权所有 粤ICP备12008183