腾讯全自研200G/400G网络的创新与实践

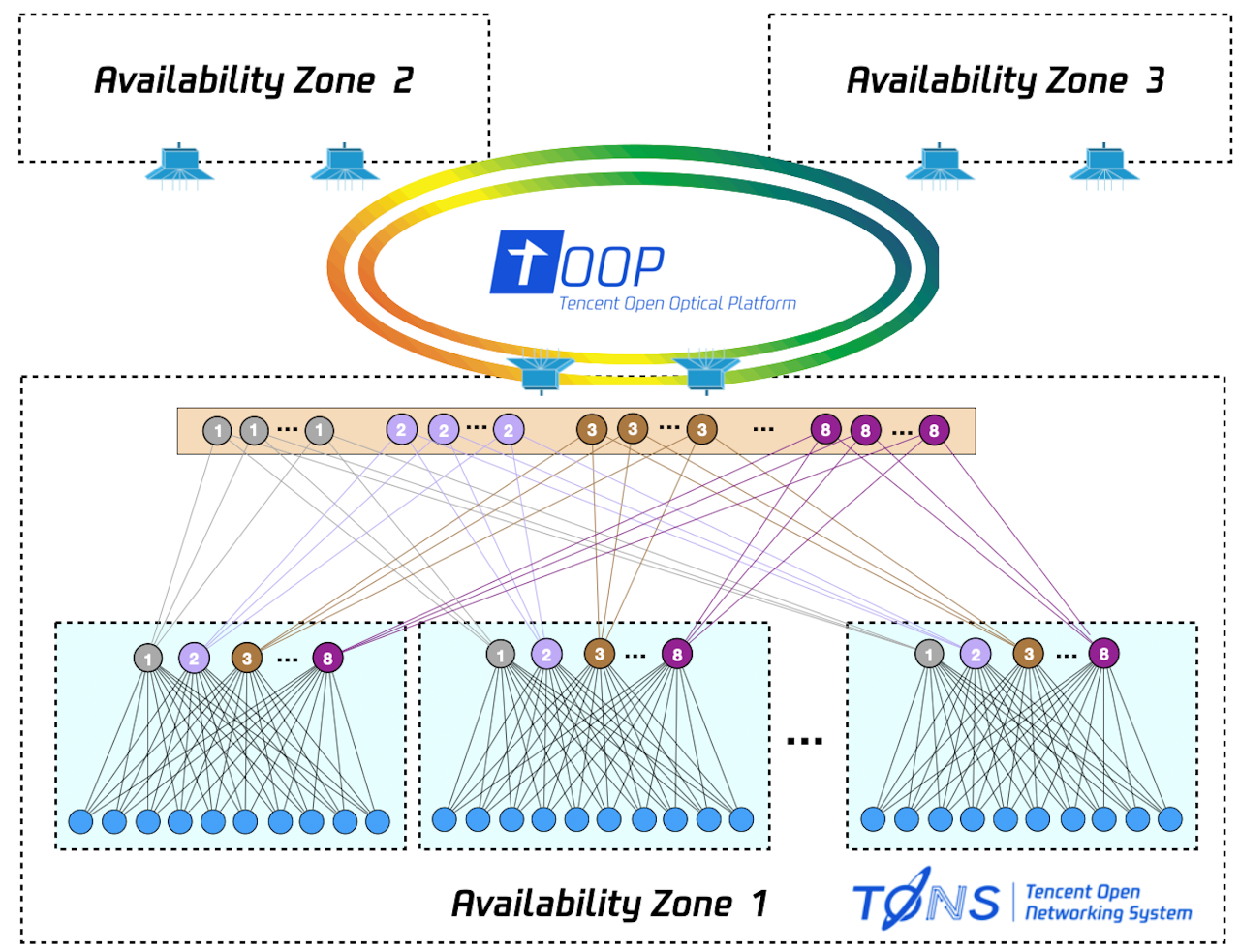

腾讯云业务的高速发展不但推动了云上层架构的创新,也对基础网络提出了更高的要求。一方面,池化让云资源的获取突破了服务器的边界,大量的数据流往返于服务器间,加大了网内的数据传输量。另一方面,随着存储介质、计算部件的性能提升,使得网络性能陡然成为新的瓶颈。在此趋势下,云基础网络向大规模、高带宽、低延迟的方向演进的诉求更加迫切。如今,腾讯网络平台部通过对自研交换机平台(TONS)以及开放光平台(TOOP)的产品升级,构建了全面自研的100G服务器接入、200G汇聚、400G数据中心互联的网络体系。

如果把当前的网络速率迭代比作交通路网升级,那么TONS与TOOP不光从硬件上拓宽了道路,更从软件上解决了复杂的交通管理难题。

其中,TONS针对DCN海量交付以及高速率接入需求,在交换机硬件上具备部件级成本透明、乐高式模块化设计、高精度状态采集以及极简无背板框架等特点,打造了高可控、高质量、低成本的交换机产品平台。在软件上通过基于开源SONiC深度自研的TCSOS,不光提供了自动化、智能化的可运营能力,更结合可编程芯片在高性能的基础上,实现高灵活性。

而TOOP针对DCI互联场景的特点,也从软硬件层面对波分系统进行了颠覆性创新。首先对波分系统做减法,极大的降低了系统复杂度,通过三个层面的解耦(光电解耦,波道解耦,相干器件解耦),实现了系统交付成本的大幅降低。TOOP硬件产品在DCI盒式产品中首次引入了可切换分段增益光放技术与Flex-grid技术,实现了极简运营的能力 。在软件上,实现1秒级全量PM telemetry上传,结合控制器软件高速迭代,全面打造高度自动化的光网络系统。

腾讯自研交换机平台——TONS

1.高可控&低成本的硬件设计

TCS8400与 TCS9400的硬件发布,宣告了其作为腾讯下一代数据中心网络架构的主要载体,提供了100G服务器接入能力以及200G/400G的汇聚能力,同时兼顾端到端的最优成本、持续供应、可靠性以及可运维能力,旨在构建高敏捷、最优性能、低成本、自服务的闭环硬件生态。集中体现在:

TCS8400 & TCS9400前视图

自主可控的乐高式部件设计

新一代交换机硬件平台由腾讯自主设计,拥有自主产权,可以方便地在ODM厂转产,使得各厂商提供的产品做到了硬件归一,网络操作系统即插即用。腾讯自研交换机采用了乐高式的部件化设计,将整机电路解耦成不同的模块与部件。其中CPU扣/底板、BMC扣板、MAC主板等模块来自于腾讯自研硬件通用平台,通过继承这些成熟应用,降低了设计、生产难度及风险。部件选型时更多考虑腾讯数据中心良好的温湿度环境,选用了最优性价比部件,如PSU选用的CRPS电源等。最终让海量供应有保障的同时,达到成本最优。

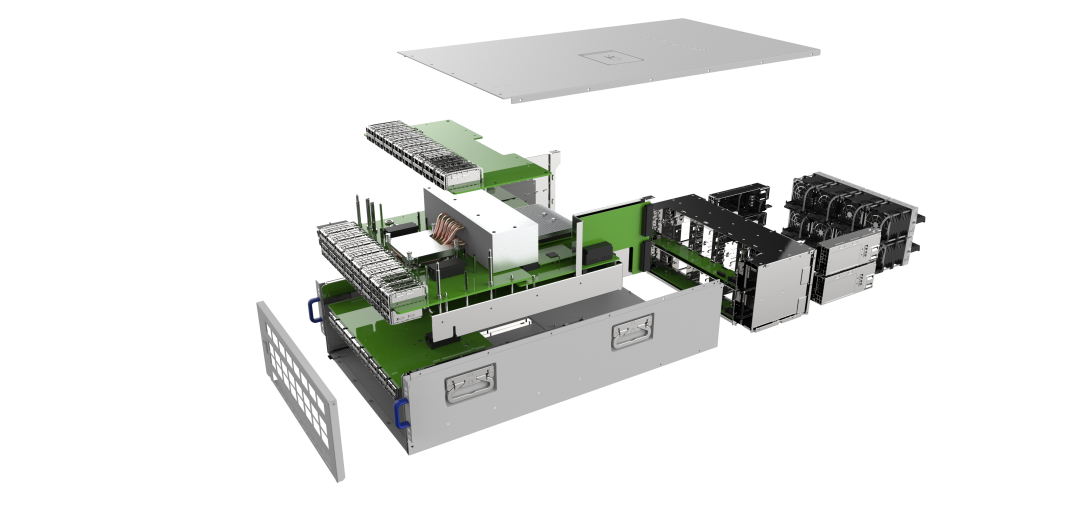

TCS9400部件拆解图

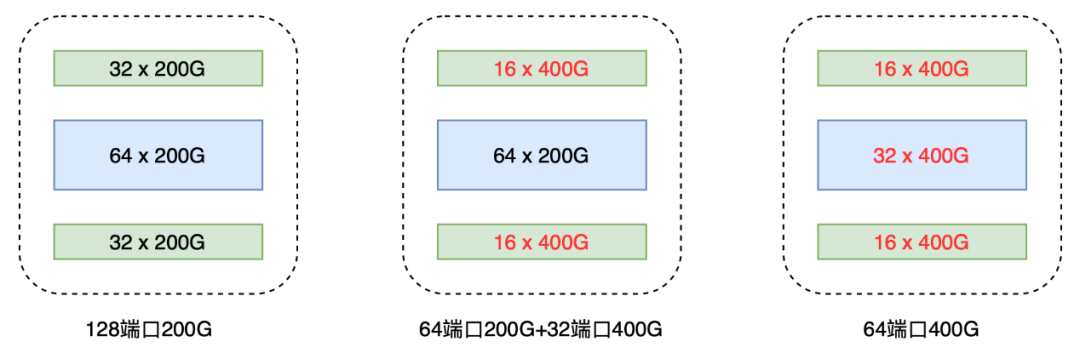

极简无背板去PHY设计

传统交换机方案多借助PHY芯片来提升SI的裕量,但是PHY芯片的引入在增加整机成本的同时、也加大了功耗以及端口link-up时间,最终拉低了设备MTBF。TCS9400的产品形态为128*200G/64*400G端口,其中速率可配置。在设计时利用多维空间尽量缩短了走线距离,在无PHY的情况下满足了SI要求, 将MTBF提升30%,单Gbit功耗降低10%,做到了硬件架构极简,成本最低。

TCS9400整机4RU高度,由于无PHY方案因为SerDes较多,要在同一平面使用多个跨板连接器,存在一定的容差风险。通过对比不同连接器3D图形间隙,结合其他连接器的容差参数计算方法,在结构件设计、定位设计、装配方案设计上做了针对性的论证和改进。同时对连接器测试指标,环温压力,测试周期等进行修订并导入。经过试验板实际测试验证,改进方案可以提高容差能力,排除容差风险。

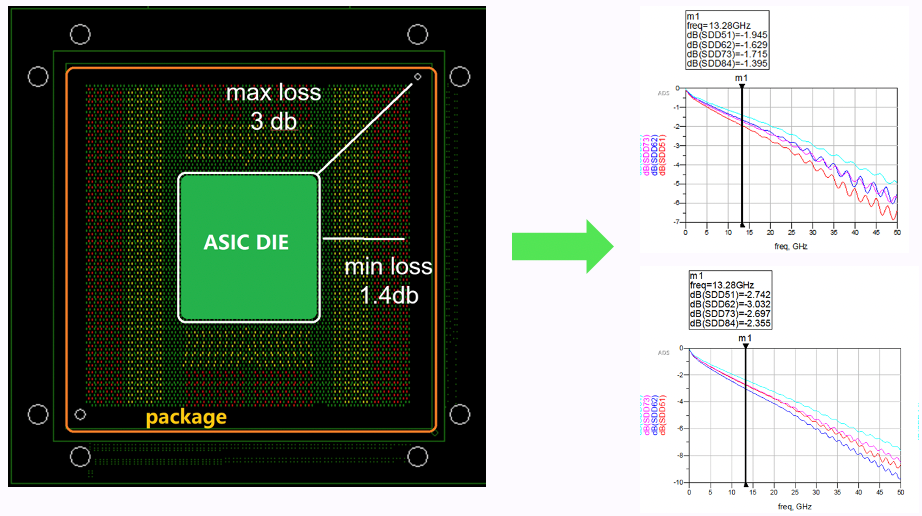

ASIC芯片I/O封装内走线长度对损耗的影响

TCS9400的SI是当下高速设计领域的顶级挑战,兼有512路56Gbps PAM4信号、700A大电流,最高密度BGA等业内难题,因此SI的设计和仿真毫无疑问是解决问题的重中之重。SI设计不但考虑了Chip Ball to IO Connector Pin-Channel的设计优化,还考虑到了芯片内不同Die走线长度的影响。把系统裕量损耗升至25%,足以应对任何不利因素。

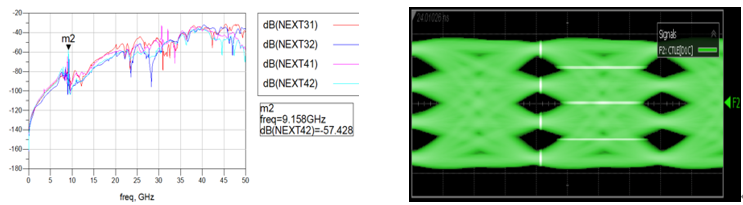

串扰优化仿真及实测眼图

在串扰优化设计中,针对跨板连接器这一最大串扰源,通过TX/RX隔离避免了系统近端串扰,全部串扰源最优化,将Fanout Via Crosstalk控制在-57db下。所有端口的一致性测试结果对比IEEE规范眼高均有60%以上的裕量。

高精度数据采集

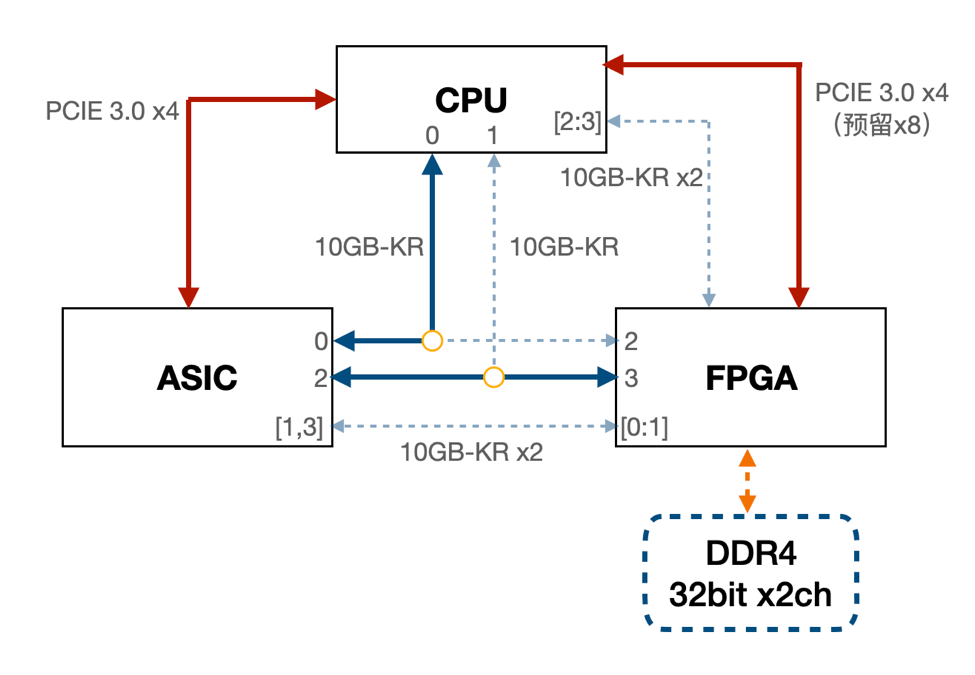

随着交换机接口带宽的快速增加,传统上基于交换机CPU的流量采集,BFD保护等技术,面临着精度低、成本高的问题。为此我们在交换机内部引入了FPGA,通过软硬协同的方式提高业务信息以及网元健康情况的采集精度,为业务的高性能诉求提供给了高可用保障。

FPGA通过两个10GE接口与交换芯片连接,构建高带宽和低时延的报文接收和发送通道,实现大吞吐的流量采样、流量注入等功能。FPGA和交换芯片通过CPU PCIe RC桥可以进行PCIe End to End通信,能够在CPU无感的情况下直接与交换芯片交互,实时获取到芯片内部状态,同时降低了轮询数据对CPU性能的消耗。

高精度数据采集FPGA

弹性设计、敏捷安装

TCS9400的128个业务口对称均匀分布,可灵活实现200G/400G端口组合,方便布线和网络架构设计,除PSU接口外,其余端口均在前面板,运维操作更便捷。侧面抬手采用航空级压铸铝材料,造型符合人体工程设计,更方便安装使用。前面板增加两个拉手,拆卸时可以通过拉手将设备从机架中拉出,实现快速替换维修。同时,线上设备可以无感知CPLD逻辑进行热升级。

通过更换端口封装支持不同速率

为了匹配TCS9400交换机的快速安装,我们开发了光纤理线架。理线架位于交换机上方,光纤沿垂直方向出线到上方理线架,内部设计了导线槽和绕柱,保证光纤布线满足最小折弯半径。光纤从理线器左右两边出线到机柜布线槽,通过理线器实现了隐藏式布线,有效保护光纤的同时,减少了人为对光纤的误动作。

2.智能化&高性能的软件设计

腾讯交换机硬件平台搭载了基于开源SONiC深度自研的操作系统。与腾讯网络建模系统相辅相成,构建了智能化的运维体系。在200G/400G网络时代,TCS OS持续改进,贴合海量规模运维以及高性能的需求,让网络拥有了更高的升级效率以及更强的可编程能力。集中体现在:

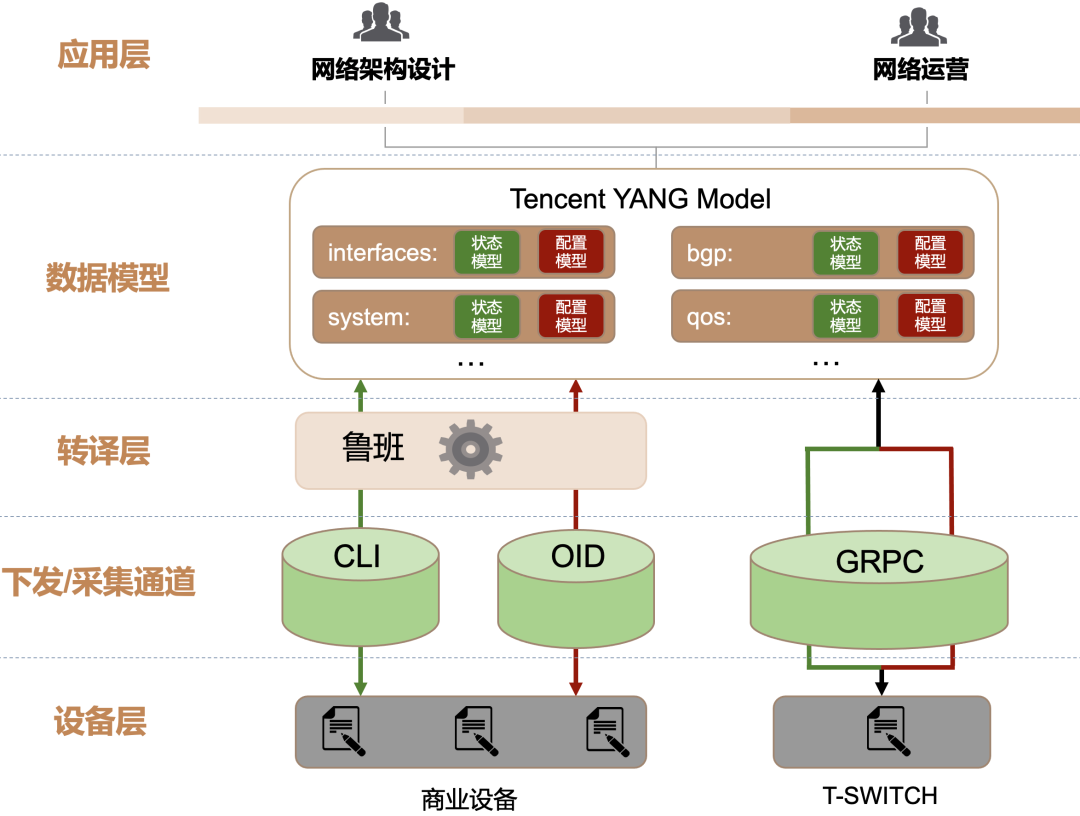

数据模型驱动的全自动化运营能力

Tencent YANG Model通过将网络特性抽象成结构化数据,为上层应用提供了灵活的可编程能力,加速应用产能的同时,也解放了上层的设计思想。TONS天然支持Tencent YANG Model,通过JSON(Tencent YANG)到JSON(Sonic YANG)的映射,将翻译层下沉至OS侧,快速支持配置与状态模型的更新,解决了建模系统中“翻译难”的问题。同时用gRPC框架替代传统CLI下发通道,提高配置下发与提取性能。

在该框架下,针对TONS的网络架构设计以及建设运营正式迈向全自动化。相关应用主要有:

1) 快速故障自愈:利用TCSOS软件快速迭代的优势,从网元级,链路级,操作系统以及芯片级四个维度填充了当前的监控盲区。并结合gRPC毫秒级下发能力,实现快速故障自愈。

2) 配置自动审计:通过每日的数据拉取以及对比,清晰的感知配置在现网的变化以及与架构标准的偏差。

3) 基于可编程的配置修改自动化:当网络架构的标准配置用YANG模型来设计时,可以利用层次化可复用的代码化思想来加速设计效率,当配置需要变更时,结合配置审计,将与配置标准的偏差自动推送到变更平台实施,整个流程与软件发布异曲同工。

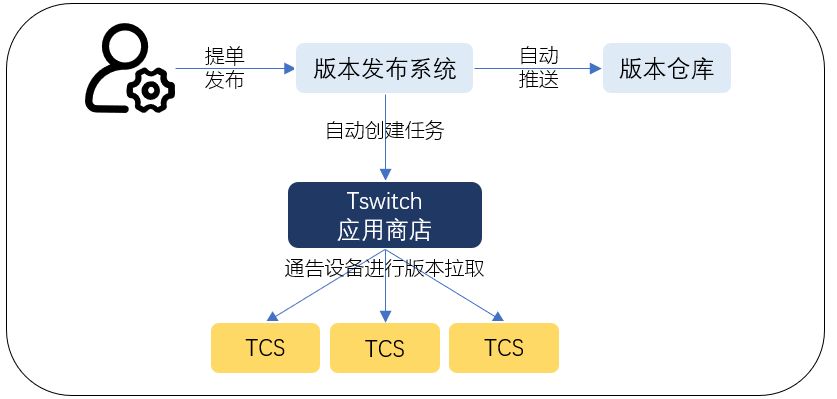

4) 基于网络应用商店的软件升级自动化:在快速迭代的云数据中心,对数以万计的网络设备进行频繁的软件升级,长久以来给运营带来了巨大挑战,我们将软件功能的发布与更新提升至以周为单位,同时避免对网络的可靠性和安全性带来影响。

相对于OS版本,应用的更新显得更为频繁,为了便于对线上设备的应用进行管理和升级,腾讯自研交换机引入了"网络应用商店",提升运营部署效率。

其过程为:

应用开发完之后,通过版本发布系统自动推送到版本仓库,并自动创建下载任务。

应用商店收到下载任务之后,根据任务信息批量通告现网设备进行应用下载。

可以看到引入应用商店之后,一旦版本发布,便自动更新到关联设备上。运营人员部署应用时无需进行版本下载,只需下发升级指令即可,这样节省掉最耗时的下载步骤。整个部署过程和手机应用下载流程很类似,应用自动更新至最新版本,然后由用户来决定是否更新,并根据授权级别判断是否安装。

网络应用商店

面向高性能网络的数据面可编程能力

进入到200G/400G网络时代,上层业务与控制软件对底层网络的特殊需求日益增多,如高带宽、低时延、大象流处理、小包线速、高精度流控等。DPDK相对优秀,可以达到很高的包转发速率,但需通过多服务器、多核负载均衡实现,传统网络设备虽然可以提供高性能网络传输,但其转发逻辑被固化,难以实现灵活的网络转发控制。

搭载新一代Trident 4可编程交换芯片的自研交换机TCS-PS,向上兼容多种业务组件及控制器,向下屏蔽底层可编程硬件差异(可编程交换芯片、FPGA等),不仅支持交换机的基础网络功能,还可以定制特殊数据面转发逻辑,性能与灵活性完美结合,可以优雅适配更多的业务场景。例如,在骨干网及专线接入点部署TCS-PS,实现基于租户及五元组的精细化流量调度及限速能力,快速解决流量热点,有效提高网络利用率;利用TCS-PS对云网关场景服务器集群进行流量卸载加速,解决大象流处理、小包线速、前置交换机HASH不均等软转发性能问题;通过TCS-PS在安全防护及流量分析场景细分业务的差异化应用,大幅减少其后端分析服务器集群的带宽及计算压力,成倍降低安全防护与流量分析的成本。

为了匹配TONS在数据中心园区提供的200G/400G能力,用于数据中心间互联的开放光网络平台(TOOP)也进行了2.0版本升级迭代。升级后光层OPC与电层TPC各自分别支持了柔性光网络能力与基于可插拔方案的单波400G产品。其中,在L0层OPC-4光层产品首次在DCI层面引入了Flex-grid功能,赋予OPC-4光层产品支持向未来的平滑演进能力,即无论是当前的400G还是未来的单载波800G/1600G,OPC-4均无需更换硬件可直接支持任意速率波长接入能力;而在L1层,TPC-4电层产品通过深化解耦思路,将开放解耦进一步下探至相干器件层面,即T2X4C8电层板卡支持多厂商DCO混合部署,打破垄断增加核心成本器件的竞争力,进一步降低了DCI带宽飞速增长的成本压力。

波长通道劣化快速辨识

TOOP旨在通过技术创新来降低CapEx与OpEx。我们在设计400G做了一些微创新。

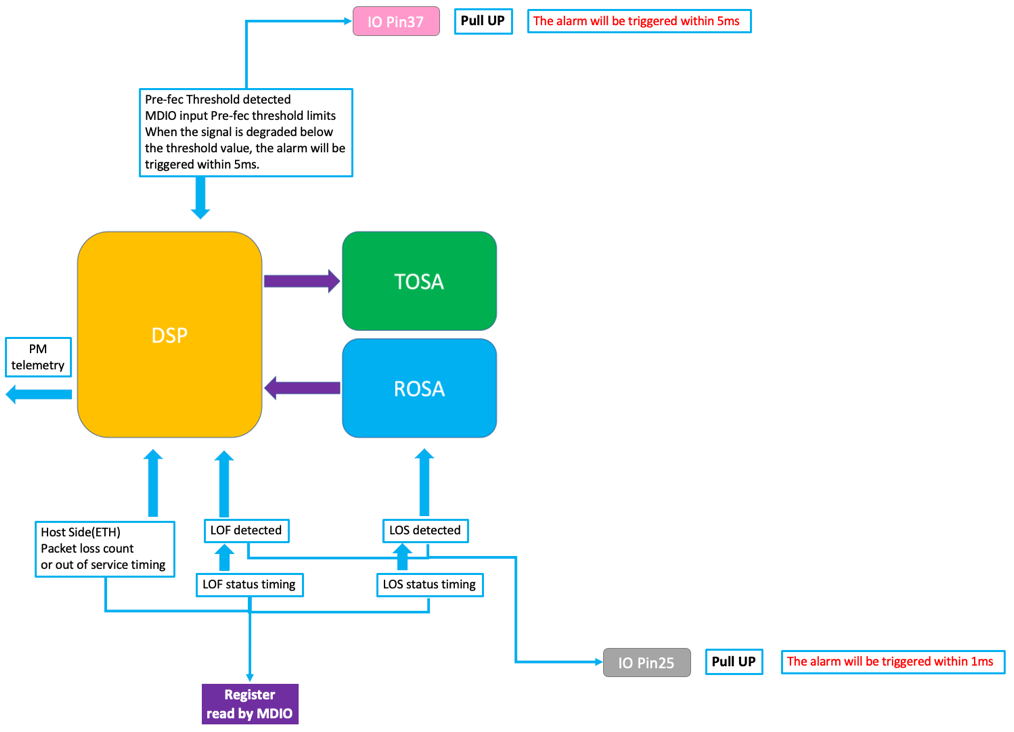

电芯片层面加了性能预判机制

相干系统通过强大的FEC(前向纠错编码)技术实现对传送的bit进行错误修正,FEC编码算法就像微信的语音转换文字功能,其具备一定的口音纠错能力。进行语音文字转换时,算法会根据语意来判断是否修正口音带来的干扰。当你的口音很重或者引入过多方言时,超过算法的容忍上限时其转换也会出错。如同我们可以用转换正确率来评估普通话标准与否一样,我们可以根据Pre-fec前向纠错误码率来评估系统的性能情况。TOOP通过CFP2-DCO的Pin37 管脚来上报pre-fec前向纠错编码超限的事件,实现了对性能劣化事件的提前关注。当DCO检测到Pre-fec越过设定门限,即拉高Pin37管脚,为业务的无损切换提供可能性。

业内首创的DSP收敛计时上报,实现业务受损时间监控

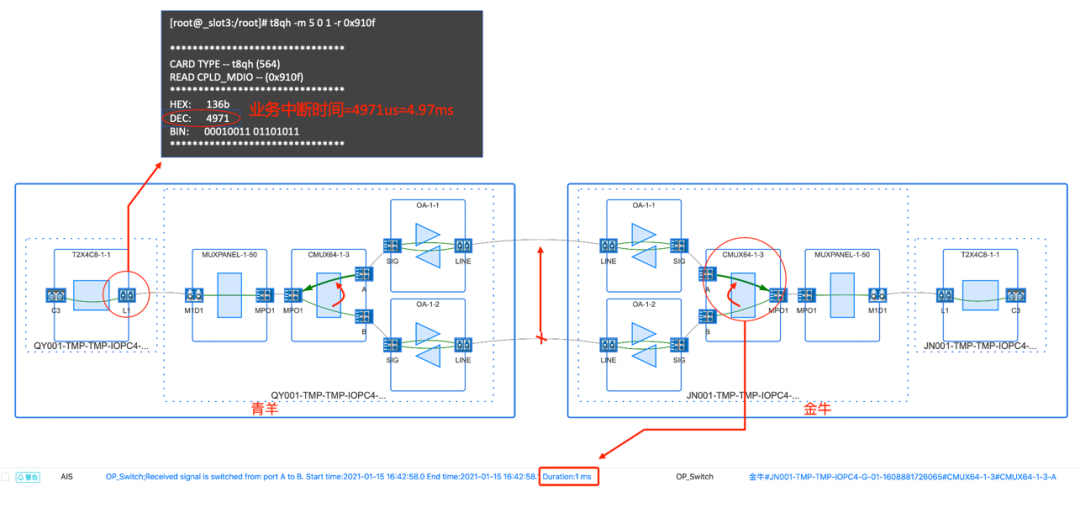

保护路径切换的业务受损时间精准计时

引入了DCO模块收敛计时功能,如上图所示,TOOP系统可以记录光路倒换过程的持续时间,包括光保护(OP)板卡的光开关切换时间与DCO模块的业务中断时间。我们定义了DCO模块的业务中断计时功能,定义0x910e(高位)与0x910f(低位)寄存器内储存了DSP收敛时间,其十进制值即收敛时间,单位us,上图中的测试结果为4971us=4.971ms,这样的数据协助我们诊断系统的性能问题。例如,当某次保护切换事件发生时,OP开关切换时间较短,而DSP的收敛时间较久,则说明线路性能余量不足,在光信号劣化至光开关切换门限值之前DSP已经产生了误码。

DSP收敛时间这个功能让我们第一次在ms级尺度上对一个瞬态进行描述,目的是减少上层业务的感知,进一步优化四纤三路由系统,让我们打造更加可靠且稳定的底层系统。

DSP 色散扫描范围自动配置

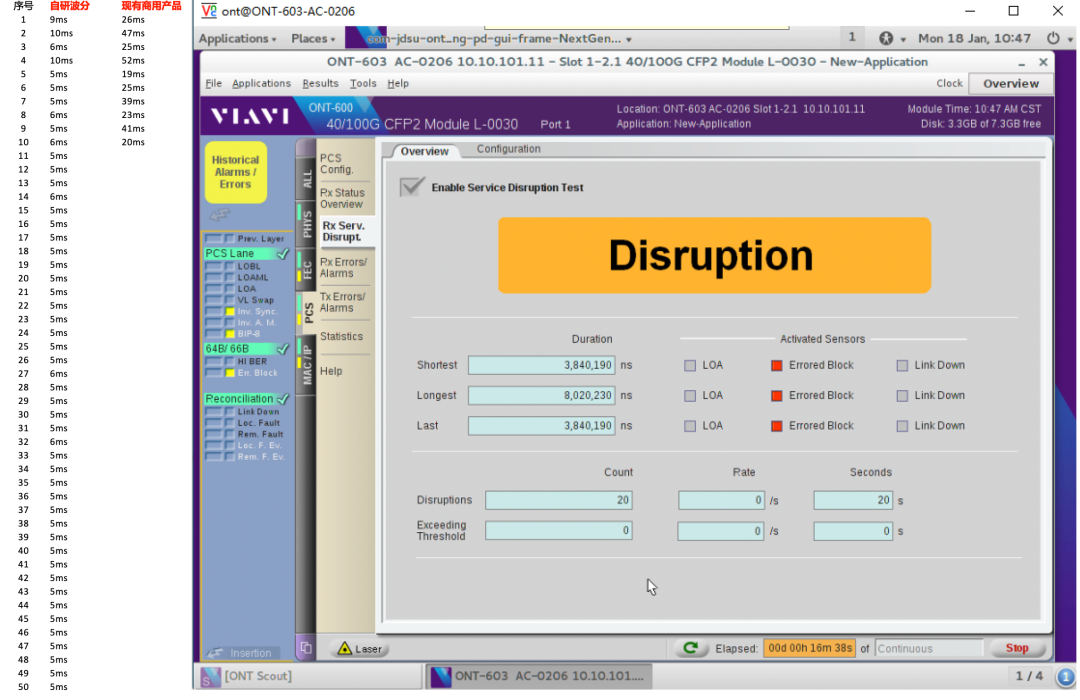

当前400G场景下,因光缆中断而引起的倒换事件对业务的影响时间由原先的100ms级别(业务层面丢失时间),降低到了10ms级别(业务层面丢失时间),从而降低光缆中断引起的业务损失。

在线路开通时,OPC-4的OTDR会探测线路实际距离(主备用路由收发双芯分别探测),通过距离配置DSP的色散扫描范围,由默认的-20000~2000ps,配置成符合主备用光缆距离的实际值,例如-5000 ~ 2000ps,得益于DSP的算法优化与色散扫描范围的自动配置,通过减少DSP的resync的色散搜索时间,进一步提升保护倒换的速度,进而减少业务受损时间。

保护路径切换导致的业务受损时间大幅缩短

根据实际测试及过,仪表显示波分系统在保护倒换过程中的切换时间最长为8ms,最短为3.8ms,上图左侧部分显示通过交换机加载流量端到端测试结果,TOOP 400G系统在倒换过程中速度更快,减少了业务受损时间,为线上服务的可靠性提供了有效保障。

DCO自动测量端到端RTT时延功能

通过下插探测信号序列,实现DCO寄存器读取线路RTT时延,从而对开通系统的线路性能指标进行准确预估,此功能为自动重路由功能提供了数据基础。

DCO内全量PM数据秒级telemetry提取

定义超过85项的PM数据通过telemetry进行秒级采集,是业内第一次将ASIC中的信息进行如此全面的采集,传统的MSA模块也没有做到如此精细化程度。进而通过数据分析提供DCO硬件故障预测与线路状态预测功能,T2X4C8单板具备硬件反馈机制,该机制使子框内OP-6单板支持通过DCO的BER触发OCH1+1保护倒换。

海量的PM数据是我们未来重点挖掘的数据宝藏,这将赋予我们一些侦测线路信息的能力。

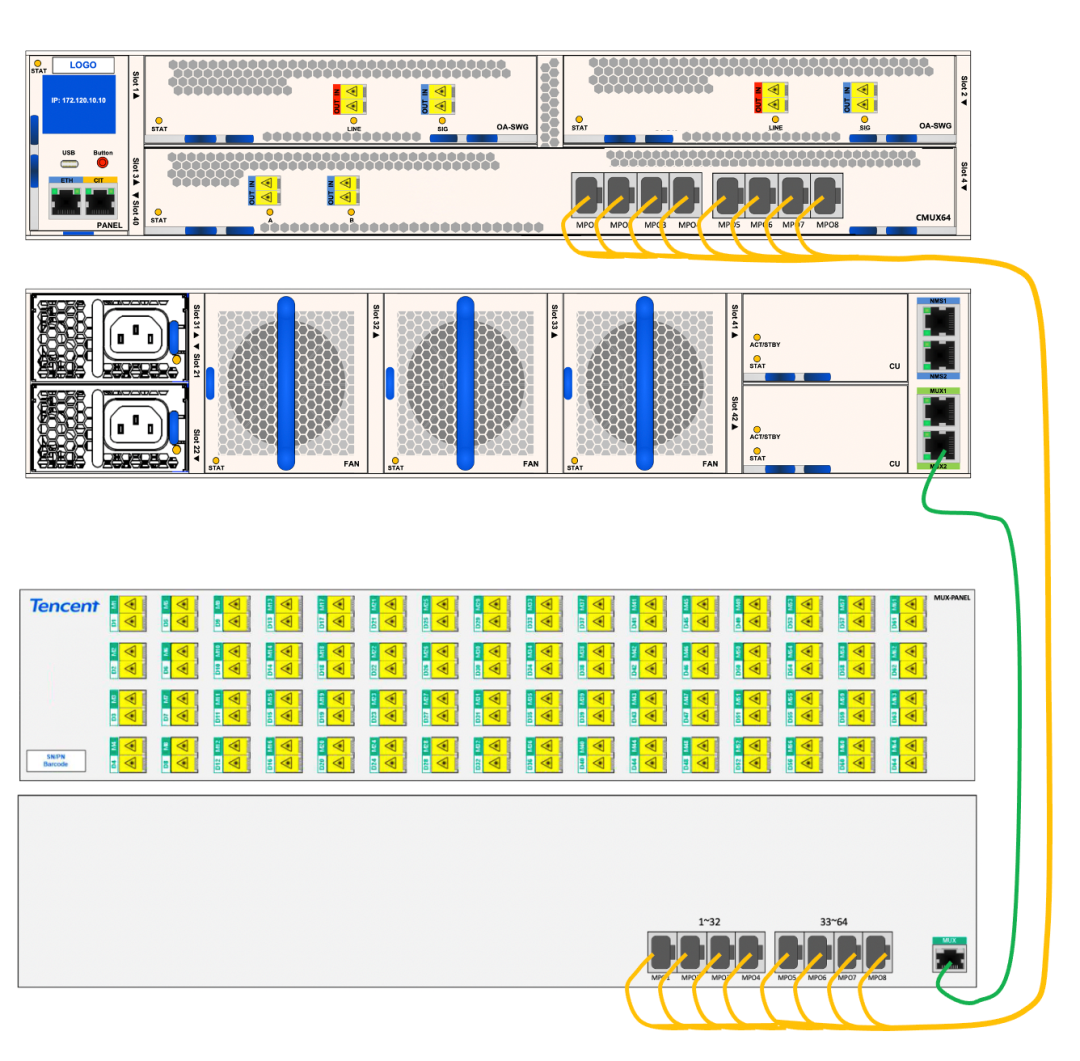

OOP向柔性网络演进,Flex-grid 为我们打造未来平台

所见即所得的可视化精准运维

TOOP首次在DCI平台引入灵活栅格技术(flex-grid),实现了柔性光网络的能力。在面对400G以及400G+场景的平滑演进提供了基础。TOOP选择了“简单”作为其设计语言。通过友好的施工管理设计,利用MUX-PAENL对64个通道进行散出,背面与前部走线设计减少布线复杂度。控制层面通过拓扑管理组件实现简明扼要的指示,避免维护时的复杂度。

CMUX-64单板与MUX-PANEL采用了专利设计,实现了低损耗的OMSP与Flex-grid应用。在点到点OMSP场景时无需额外增加OP单板即可实现,在采用OCH1+1场景或无需光层保护场景时也不会额外增加插损。整体功率计算符合链路落波与合波需求,满足400G及400G+场景的需求,该系统可以平滑向未来演进,进而降低光层的重复投资与提升频谱利用率。

高品质Flex-Grid让光层基础设施更稳定更长寿

CMUX-64所采用的WSS器件具备优秀滤波特性,让我们减少了对DCO模块内置TOF的需求,进一步降低DCO模块的成本。同时Flex-grid赋予我们无需标准化FEC,两端IDC的不同DSP厂商的DCO可以自适应匹配,无需繁琐的现场操作。这里划重点,TOOP产品的设计语言是“简”,我们希望现场处理问题的方式就是安装与替换,缩短系统开通与故障处理的时间,提升业务的可用率。电层设备与合波器之间的频率分配,互联关系等问题可以做到无图纸化施工,我们引入了自适应功能来实现匹配波长功能。同时CMUX-64可以针对不同模块的发射功率差异与不同波特率的问题,包括正在测试中的基于PCS-16QAM的69Gbaud CFP2-DCO的高性能 400G所需81.5GHz频谱间隔应用,采用Flex-grid可以很好的解决。

结语

路宽难平,快马难驯。回首腾讯在200G/400G网络中的创新与实践之路,我们不仅仅是为了贴合业务算力要求而做了速率提升,更是通过构建端到端全面自研的底层基础设施,并搭载智能化的网络系统,借助自主可控创造了高速率,也驯服了高速率,最终为云业务提供高带宽、低延时、更灵活的云网络服务。相信在该体系的奠基下,后续腾讯网络会持续稳步迈向400G/800G网络时代。

本文地址:http://www.iccsz.com//Site/CN/News/2021/05/28/20210528074026550684.htm 转载请保留文章出处

关键字: 腾讯 TOOP

文章标题:腾讯全自研200G/400G网络的创新与实践

2、免责声明,凡本网注明“来源:XXX(非讯石光通讯网)”的作品,均为转载自其它媒体,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。因可能存在第三方转载无法确定原网地址,若作品内容、版权争议和其它问题,请联系本网,将第一时间删除。

联系方式:讯石光通讯网新闻中心 电话:0755-82960080-168 Right

- 设置首页 | 光通讯招聘 | 企业搜索库 | 广告服务 | 联系我们 | 保护私隐 | 公司介绍

Copyright ? 2009 ICCSZ.com Inc. All Rights Reserved. 讯石公司 www.iccsz.com版权所有 粤ICP备12008183号-1