用光速跑云端AI推理 美国公司推光子芯片,商业产品明年见

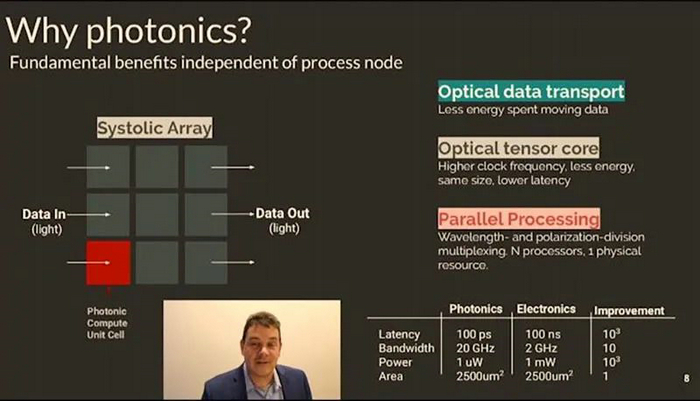

在刚落幕不久的Hot Chips 32大会上,脱胎于麻省理工学院的初创公司Lightmatter展示了用于通用AI加速的光子计算测试芯片。该处理器利用硅光子和MEMS技术,以光速处理矩阵向量乘法,由毫瓦级激光光源供电。据悉,在相同芯片面积上,光子器件的速度比电子器件快1000倍,而功耗仅有电子器件的1/1000。

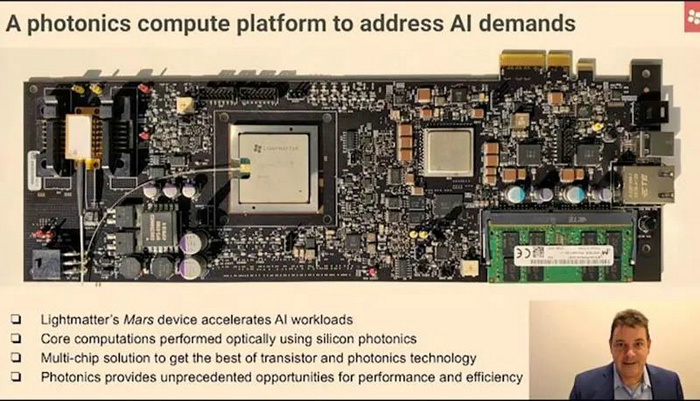

Lightmatter于2017年在马萨诸塞州波士顿市成立,目前有46名员工,已从Google Ventures等投资方处融资3300万美元,拥有30项专利。作为最早面向AI推理定制光子芯片的公司之一,Lightmatter将于2021年秋季推出其首款商业产品——搭载光子计算芯片的PCIe卡,专为数据中心AI推理工作负载而设计。

能效提升20倍,吞吐量提高5倍

得益于硅光子技术的进步,硅芯片上的光传输成为可能。光子芯片通过采用与传统基于晶体管的电子器件完全不同的物理学原理,可实现更快的性能、更低的能耗。Lightmatter首席执行官尼克·哈里斯称:“我们可以利用现有AI数据中心,将能耗降低为原来的1/20,将物理空间减少为原来的1/5。”

据他介绍,这只是Lightmatter正在打造的第一代产品,未来还有很长的路线图。哈里斯强调,此次展示的测试芯片只是作为其技术的演示,并不是为了在基准测试中有出色表现。但他坚持认为,在实际应用中,该演示芯片仍将击败AI加速领域的市场领导者——英伟达A100 GPU。据哈里斯介绍,与A100相比,其光子芯片在BERT和ResNet-50推理等工作负载上可提供20倍的能效和至少5倍的吞吐量。

格芯代工,采用3D封装堆叠

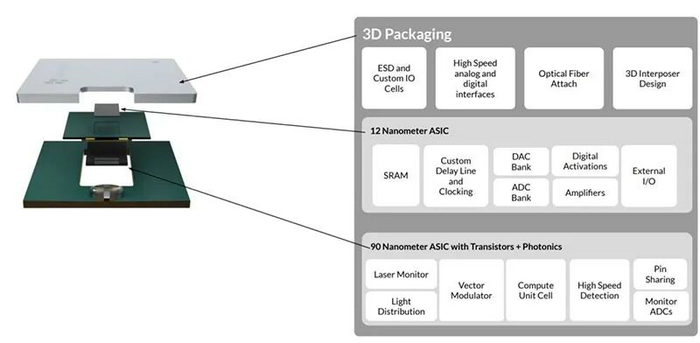

Lightmatter的芯片由两个垂直堆叠的芯片组成,整个芯片面积为150平方毫米,两个裸片均由格芯标准CMOS工艺制造,包含超过十亿个FinFET晶体管、数万个光子算术单元和数百个记录设置数据转换器。

上方是一个12nm ASIC(Lightmatter副总工程师Carl Ramey在Hot Chips演讲时介绍的是14nm ASIC),用于存储内存和控制下方作为计算引擎的90nm光子芯片裸片。该光子处理器具有64 x 64光子矩阵向量乘积计算器,可在标准数据中心工作温度下运行,总延迟时间不到200皮秒(1万亿皮秒=1秒),比晶体管计算要快几个数量级,晶体管计算需要多个时钟周期。计算引擎由50兆瓦的激光驱动。哈里斯认为,这种低功耗光子计算芯片的优势之一,是可以与控制/内存ASIC进行3D堆叠。基于晶体管的计算芯片会散发过多的热量。堆叠的芯片缩短了ASIC上的操作数存储区与光子芯片上的计算元件之间的轨迹线——从数据转换器到光子计算引擎的距离不到总路径的1毫米。反过来,这降低了延迟和功耗。哈里斯说:“这里有一个很好的正反馈循环”, “节省功耗使我们堆叠,而堆叠可以节省更多功耗。”

更高速度、更低功耗是如何实现的?

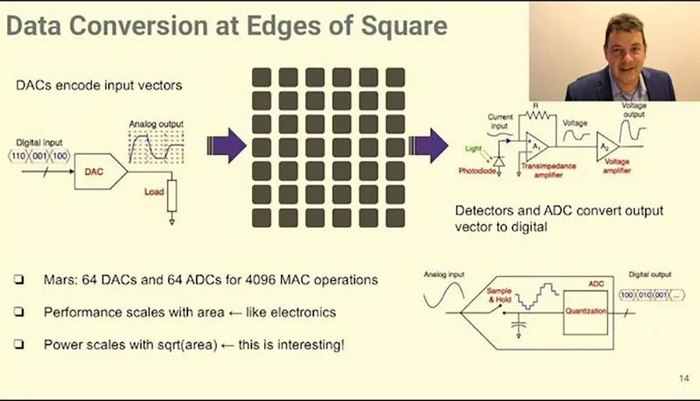

Lightmatter光学计算阵列由DAC和ADC模块封装,作为与数字电路的其余部分的接口。DAC接收数字输入信号,将其转换为模拟电压,并使用该电压来驱动激光器(该技术已在光纤发射器中广泛使用)。

来自该激光器的光,在进入马赫曾德尔干涉仪(MZI)后,相干光分为两束,每半束光的相位调整不同,将具有不同相位的光束组合会导致相长或相消干涉,从而有效地调制通过MZI的光的亮度(该调制可被视为乘法运算)。

在波导(承载光的“电线”)相遇之处,信号被有效地加在一起,这是光MAC的基础。计算阵列输出的光到达光电二极管,通过机械手段实现MZI中的关键操作,改变光的相位。

Lightmatter副总工程师Carl Ramey在Hot Chips演讲解释说,其光子芯片使用了纳米光学机电系统(NOEMS)。与MEMS器件类似,波导结构通过在下面蚀刻而悬浮,然后通过向其上方和下方的电容器板添加电荷来偏转。这成功地改变了光的相位所需的数量,并且所需功率极低。

“NOEMS设备具有一些非常惊人的性能,” Ramey说。“它们的损耗极低,静态功耗几乎为零。我们只是将一些电子倾倒到小电容器上,几乎没有泄漏——电容足够小,致动所用的动态功率也很小。(结构)也能以相对较高的速度启动,最高可达数百兆赫。”

Ramey说,Lightmatter的演示芯片具有64 x 64计算元素,但可以很容易地扩大规模。

据他介绍:“类似于基于晶体管的脉动阵列,计算量与面积成线性比例关系,“延迟也随着阵列的尺寸而缩放。因此,在一个典型的流水线晶体管设计中,您需要64个时钟周期来执行这些操作,从左到右。我们的延迟也随阵列尺寸而定,但是速度要快三个数量级。因此,即使是1000 x 1000的阵列,其延迟也会远低于纳秒。”

有趣的是,光子计算阵列消耗的功率与面积的平方根成比例。这是因为功耗主要归因于数据转换。

“当我们将每个新元素添加到阵列中时,我们将获得更高的性能,但是我们只需要付出功率平方根的代价即可。” Ramey说,“因此,我们制造的芯片越大,实际上它们的效率就越高。这与电子系统有很大不同,电子系统只是线性扩展:性能越高,功耗越大。”

除了与计算相关的能量外,还有与在芯片周围移动数据有关的能量(当今基于晶体管的大型AI芯片在硅片上移动数据可能要消耗50-100W功率)。而通过光学计算,以光学方式移动数据,意味着不需要电源,从而节省了很多钱。

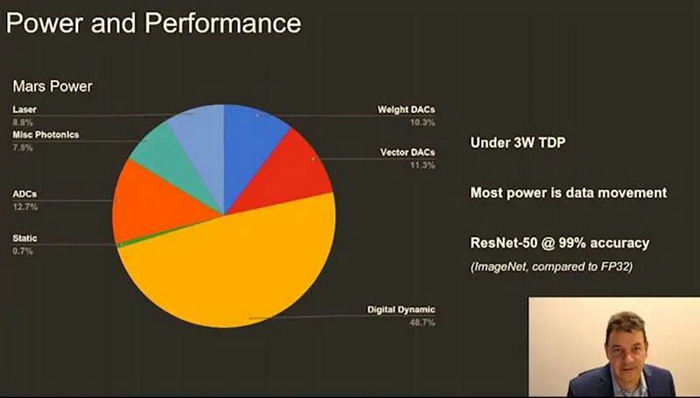

结果是,光子计算设备的运行功耗不到3W,仅是其他计算方法每次推理操作所消耗能量的一小部分。

支持同时执行多个AI推理任务

光子计算的另一个有趣功能是并行处理能力。与光通信中使用的技术类似,可以将多个独立的数据流编码到不同波长的光上,并同时馈入计算引擎。

这意味着光学计算芯片可以同时执行多个AI推理任务。“这是光子计算的一个非常独特的特性,” Lightmatter首席执行官Nick Harris说,“这意味着您有一个物理资源,一个处理器,但它的作用就像一排处理器。”

虽然指定的光谱(1310至1600nm)在理论上可以适合至少1000路,但哈里斯说,因激光技术还不成熟,目前仅支持8路。

结语:落地将是艰巨的挑战

据悉,Lightmatter的目标客户是当今的数据中心,包括高性能计算等可扩展系统。自动驾驶技术是一个遥远的未来发展方向,不过哈里斯承认,进入这一领域所需的可靠性工程将是“一项艰巨的任务”。

Lightmatter具有完整的软件堆栈,支持TensorFlow、PyTorch、ONNX等机器学习框架。哈里斯说,他们的目标是在两个机器学习框架之间实现即插即用。对于初创企业而言,首要挑战之一可能是如何使持怀疑态度的客户理解和接受光子计算的整个概念。

如何做到这一点呢?哈里斯回应称:“这是一个艰巨的挑战”。他介绍道,自1960年代以来的计算历史上,从来没有一种技术取代过电子晶体管做计算,人们已经尝试过,但从未成功。“我认为这是您第一次看到它的实现,而我们销售它的方式就是通过展示它的运行。”哈里斯说。

文章来源:EE Times,AnandTech

本文地址:http://www.iccsz.com//Site/CN/News/2020/09/01/20200901010342631286.htm 转载请保留文章出处

关键字: AI 光子芯片

文章标题:用光速跑云端AI推理 美国公司推光子芯片,商业产品明年见

※我们诚邀媒体同行合作! 联系方式:讯石光通讯咨询网新闻中心 电话:0755-82960080-168 Right

- 设置首页 | 光通讯招聘 | 企业搜索库 | 广告服务 | 联系我们 | 保护私隐 | 公司介绍

Copyright ? 2009 ICCSZ.com Inc. All Rights Reserved. 讯石公司 www.iccsz.com版权所有 粤ICP备12008183号-1